行政院國家科學委員會專題研究計畫 成果報告

人與機器人於日常生活與緊急救助中之協力合作(I)

研究成果報告(精簡版)

計 畫 類 別 : 個別型 計 畫 編 號 : NSC 95-2221-E-002-433- 執 行 期 間 : 95 年 08 月 01 日至 96 年 09 月 30 日 執 行 單 位 : 國立臺灣大學資訊工程學系暨研究所 計 畫 主 持 人 : 王傑智 計畫參與人員: 碩士班研究生-兼任助理:游岳齊 報 告 附 件 : 出席國際會議研究心得報告及發表論文 處 理 方 式 : 本計畫可公開查詢中 華 民 國 96 年 09 月 27 日

行政院國家科學委員會補助專題研究計畫

行政院國家科學委員會補助專題研究計畫

行政院國家科學委員會補助專題研究計畫

行政院國家科學委員會補助專題研究計畫 成果報告

成果報告

成果報告

成果報告

人與機器人於日常生活與緊急救助中之協力合作

計畫類別:

████個別型計畫 □ 整合型計畫

計畫編號:NSC 95 - 2221 - E - 002 - 433

執行期間: 95 年 8 月 1 日至 96 年 9 月 30 日

計畫主持人:王傑智

共同主持人:

計畫參與人員: 游岳齊、吳郁君

成果報告類型(依經費核定清單規定繳交):

████精簡報告 □完整報告

本成果報告包括以下應繳交之附件:

□赴國外出差或研習心得報告一份

□赴大陸地區出差或研習心得報告一份

█ █ █ █出席國際學術會議心得報告及發表之論文各一份

□國際合作研究計畫國外研究報告書一份

處理方式:除產學合作研究計畫、提升產業技術及人才培育研究計畫、

列管計畫及下列情形者外,得立即公開查詢

□涉及專利或其他智慧財產權,□一年□二年後可公開查詢

執行單位:國立臺灣大學資訊工程研究所

中 華 民 國 96 年 9 月 20 日

附件一中文摘要

本計畫旨在建立人與機器人於日常生活中協力合作之機制。計畫成果著眼於兩大課 題:(一)藉著建立人與機器人間方便使用之介面,可使人機互動更自然順暢;(二)以對 環境的更高階感知來增進機器人輔助人類的能力。此類研究之發展能夠協助機器人在日常 生活中發揮其最大效用;本計畫的主要具體成果包括:(一)以數位攝影機辨識使用者手部 不同手勢以執行其相對應命令及(二)以雷射測距儀偵測、追蹤與辨識市區中各式移動物 體,並進一步辨識出行車違規狀況,以幫助使用者更佳地掌握交通狀況。使用者之手勢辨 識系統利用Scale Invariant Feature Transform (SIFT)特徵處理取得相機影像中之特徵,並 結合 Adaboost 學習演算法辨識出不同之手勢。在交通狀況的感測部份,我們提出以 Variable Structure Multiple Model Estimation Framework 為基礎,結合各式動態運動模型、靜止模型、 與場景互動模型(scene interaction model)、和鄰近物體互動模型(neighboring object interaction model),來完成擁擠市區環境中各式移動物體之偵測與追蹤,並辨識出違規事件。關鍵詞:人機互動、手勢辨識、場景互動模型、鄰近物體互動模型

英文摘要

In this project, a mechanism for human robot coordination in our daily life is established with a smart human robot communication interface and a higher level scene understanding capability. Regarding the smart human robot communication interface, a camera-based hand posture recognition using SIFT with Adaboost is proposed to provide natural and smooth interaction between the robot and the users. With respect to high level scene understanding, a ladar-based interacting object tracking system using the variable structure multiple model estimation framework with the moving models, the stationary process model, the scene interaction model and the neighboring object interaction model is established to solve the

challenging tracking problem in crowded urban areas. In addition, unusual activity recognition is accomplished straightforwardly.

Keyword: human-robot interaction, hand posture recognition, scene interaction model, neighboring object interaction model

1. 前言

本計畫規劃以三年完成建立人與機器人於日常生活與緊急救助中協力合作之機 制,獲得執行一年之經費補助。第一年執行年度內,本實驗室以其他計畫補助經費來建 立輪椅型機器人平台 NTU PAL1(圖 1),並以此平台為基礎,建立與人互動之使用介面。 輪椅型機器人優點在於可作為室內外兩用的機器人平台,輪椅平台由於原本設計即 為負載一個成年人的重量,除了可做為機器人搬運物品以及載人的服務外,在輪椅平台 上並可方便的架設各式感測器,做為機器人對於環境偵測與感知的用途。 圖 1. 輪椅型機器人平台 NTU PAL12. 研究目的

想達成人與機器人協力合作的目標,首要工作即為使得機器人具有與人互相溝通的 能力,需建立方便使用的人機介面(Human Robot Interface)。本計畫欲建立方便使用的 人機介面,去除掉一般社會大眾對於電腦的刻板印象,例如需經由滑鼠或鍵盤將命令下 達給電腦。方便使用的介面會使人願意與機器人共同合作,進而在日常生活或急難救助 時能夠發揮最大的效果。3. 文獻探討與研究方法

3.1 人機互動-手勢辨識 人與人溝通的時候,肢體語言是一個相當重要的部分,本計畫藉由使用者手部不同的 手勢,藉由數位相機的擷取,使得機器人能夠辨識出使用者不同的手勢所代表的命令,而 進行相對應的反應。相機的影像首先經過scale invariant feature transform (SIFT) [1]特徵處理,SIFT為一強健 的特徵表示法,對於影像的旋轉、縮放、光線照度、視角及雜訊具有高度的容忍性,然而

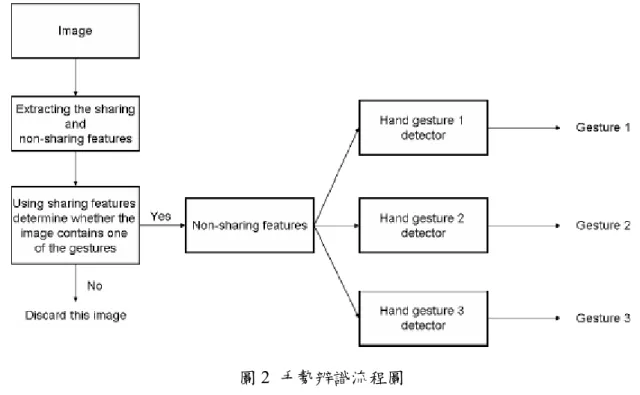

當應用在物體辨識時,常由於對應的特徵區塊太少而有困難。此時引入Adaboost[2]分類演 算法,Adaboost演算法結合數個分類能力較弱的分類方法,藉由在訓練過程中,調整不同 的弱分類法所佔的比重,統整成一能力較強的分類方法。 在手勢的辨識上,我們結合了SIFT和Adaboost的方法,整套系統的流程圖描述在圖2 中。首先藉由Adaboost訓練強分類法,藉由一系列經過標記的手勢或非手勢影像訓練,可 得到一具有較強能力的分類法。而當機器人透過相機擷取影像時,此影像會被找出SIFT特 徵,並和先前Adaboost訓練出的分類法比較,首先透過比較多個手勢共同的特徵,此時會 過濾掉不符合的影像,再藉由不同手勢所具有的不同特徵,來分辨出使用者的不同手勢。 圖 2 手勢辨識流程圖 3.2 人機互動-環境感知 除溝通介面的建立之外,對於日常生活中,機器人如何輔助人類也是一個重要的方 向。本計畫亦藉由裝載於機器人正前方之雷射測距儀,利用機器人對於十字路口的行車 狀況及違規狀況加以分別,以幫助使用者掌握更佳的交通狀況。

移動物體追蹤(Moving object tracking)一直是機器人領域一個重要的課題,透過移動 物體追蹤可讓機器人除了了解周圍的靜態環境外,對於會移動的物體,如人、車等,能 有更進一步的感知能力,也由於對於人或是人所駕駛的車輛具有追蹤能力,使得機器人 與人能有更好的互動。在本團隊所提出的同時定位、建地圖及移動物體追蹤演算法 (Simultaneous localization, mapping and moving object tracking)中[3,4],假設了靜態環境 和移動物體間,以及移動物體彼此之間是互相獨立的,然而此一假設並不符合一般日常 生活中常見的狀況。在交通的狀況裡,車輛必須遵行一定的移動方向,此即靜態環境和 移動物體的關係;而在車輛行進時,後方的車輛的速度會受到前方車輛的速度限制,此 即為移動物體間的關係。根據此想法,進一步提出場景互動模型(scene interaction model) 和鄰近物體互動模型(neighboring object interaction model),分別處理以上兩種狀況[5]。

圖 3 中,分別顯示了車道與十字路口的格網地圖(grid map)中的一格,除了一般格 網地圖所具有的佔有機率在 z 軸方向表示外,在 x-y 平面上表示了八個可能移動方向, 並在該方向上以長度代表速度。圖 4 中則顯示了機器人建出的格網地圖與實際照片比 較,在不同交通號誌的狀況下,路口有不同的車輛通行狀況,藉由解讀格網地圖可使機 器人了解現在的十字路口交通狀況。場景互動模型即利用此格網地圖來做移動物體追

蹤,將物體所處在的環境資訊,加入做移動物體追蹤時的預測(prediction)步驟。當欲追 蹤物因雜訊或遮蔽等原因而無法觀測到時,亦可利用此模型來做預測。當欲追蹤物附近 有其他物體時,我們引入鄰近物體互動模型,考慮物體間的互相影響,並將此同樣加入 追蹤時的預測步驟。 圖 3 包含方向、速度與該格點機率格網地圖。左圖為車道,右圖為十字路口 圖 4 復興南路與辛亥路交叉路口之格網地圖(上)與實際照片(下)

4. 結果與討論

4.1 人機互動-手勢辨識 在手勢辨識的部分,我們使用三個基本手勢,分別是「六」、「開掌」與「拳頭」。 圖 5 中綠、紅及藍色的小方框分別代表偵測出的三個手勢的 SIFT 特徵,該張影像上方 有出現字代表所偵測出的手勢種類,圖 A 中上方三圖為正確偵測的結果,而下方三圖 則為錯誤的例子。圖 5 手勢偵測結果:正確(上方三張圖),錯誤(下方三張圖) 在圖 6 中,展示了對於不同視角所拍攝到了同一個手勢的偵測結果,我們的所提出 的方法可以成功的在 40 度的旋轉角度內仍能成功偵測出結果。 圖 6 不同視角下的手勢偵測結果:(a)(f)無法偵測(b)(c)(d)(e)成功偵測 讀 者 可 在 [6] 獲 得 更 多 演 算 法 細 節 , 並 可 在 下 列 網 址 下 載 系 統 展 示 影 片 http://www.csie.ntu.edu.tw/~bobwang/videos/HandPostureRecognition4HRI.wmv 4.2 人機互動-環境感知 在圖 7 中,方框代表現在時刻的物體位置,方框後面跟著的線條代表過去一定時間 內的軌跡。此結果利用上述所提到的,場景互動模型與鄰近物體互動模型的追蹤,因為 在複雜的路口,常會發生物體互相遮蔽的現象,而用傳統的追蹤方法常會誤判物體因遮 蔽而消失又出現,本實驗改善了此情形。

圖 7 復興南路與辛亥路口之移動物體追蹤 在圖 8 中,路口紅綠燈狀況應為左右通行,因此大部分的軌跡皆為左右方向,而上 下軌跡出現,即可判斷為不正常情形,此即為闖紅燈的狀況。 圖 8 不正常現象(闖紅燈)的偵測 讀 者 可 在 [5] 獲 得 更 多 演 算 法 細 節 , 並 可 在 下 列 網 址 下 載 系 統 展 示 影 片 http://www.csie.ntu.edu.tw/~bobwang/videos/InteractingObjectTracking.mpg

5. 計畫成果自評

透過本計畫之執行,我們成功地建立了能促進機器人在日常生活中之應用的人機互動 介面,包括手勢辨識系統及環境感知系統。 我們能運用手勢辨識系統準確地分辨出影像中數種不同的使用者手勢,並能處理背景 中之雜訊問題,使得使用者能夠藉由變化手部動作與機器人進行溝通、下達命令並取得所 需之服務,藉此創造出方便使用且自然的人機介面以幫助機器人在日常生活中被接受及妥 善利用。 除現階段採用之 SIFT 特徵辨識外,運用其它種特徵表示將替此辨識系統提供更高的準 確定,加強其可靠性。又為整合手勢辨識系統至機器人平台,完整建構出此一人機互動模 式,我們將發展此手勢辨識之即時操作系統。此外,更多不同類別的手勢也將被加入系統 的辨識中,以提供使用者更多不同的互動選項。 而藉由場景互動模型及鄰近物體互動模型的引入,我們改善了傳統的動態物體追蹤方 法易造成誤判的弱點,成功地在複雜的路口感測交通情況並發現交通違規等異常狀況,有 效地輔助人類掌握交通狀況。 未來我們將考慮更多不同的動態物體間互動關係以處理更複雜之環境感測問題;另外 藉由在不同環境下的資料蒐集及分析,我們將能得到其它種類之場景互動模型,使得此環 境感測系統能應用在如居家、辦公室等各式不同的環境下。6. 參考文獻

[1] D. G. Lowe, “Distinctive image features from scale-invariant keypoints,” International Journal of Computer Vision, vol. 60, no. 2, pp. 91–110, 2004.

[2] P. Viola and M. J. Jones, “Robust real-time face detection,” International Journal of Computer Vision, vol. 57(2), pp. 137–154, 2004

[3] C.-C. Wang, C. Thorpe, and S. Thrun, “Online simultaneous localization and mapping with detection and tracking of moving objects: Theory and results from a ground vehicle in crowded urban areas,” in Proceedings of the IEEE International Conference on Robotics and Automation (ICRA), Taipei, Taiwan, September 2003.

[4] C.-C. Wang, “Simultaneous localization, mapping and moving object tracking,” Ph.D. dissertation, Robotics Institute, Carnegie Mellon University, Pittsburgh, PA, April 2004.

[5] Chieh-Chih Wang, Tzu-Chien Lo and Shao-Wen Yang, Interacting Object Tracking in Crowded Urban Areas, Proceedings of IEEE International Conference on Robotics and Automation (ICRA'07), 10-14 April 2007, Roma, Italy.

[6] Chieh-Chih Wang and Ko-Chih Wang, Hand Posture Recognition Using Adaboost with SIFT for Human Robot Interaction, Proceedings of the 13th International Conference on Advanced Robotics (ICAR), 21-24 August 2007, Jeju, Korea.

出席國際學術會議心得報告

計畫編號 95-2221-E-002-433- 計畫名稱 人與機器人於日常生活與緊急救助中之協力合作(I) 出國人員姓名 服務機關及職稱 王傑智 國立臺灣大學資訊工程學系暨研究所 助理教授會議時間地點 August 21-24, Jeju, Korea

會議名稱 The 13th International Conference on Advanced Robotics (ICAR)

發表論文題目 Hand Posture Recognition Using Adaboost with SIFT for Human Robot Interaction

1、 參加會議經過

ICAR 為兩年舉辦一次之重要機器人學國際會議。 在台大主任秘書傅立成教授強力邀約 下,我們將台大機器人知覺與學習實驗室最新發展之多手勢辨識系統與演算法軟體發表 在會中,發表後獲得許多迴響。會後得知我們所發表之論文被選入Springer-Verlag Lecture Notes in Control and Information Sciences (LNCIS) 中發表。台灣機器人相關學者與會的有主任

秘書傅立成教授與電機系連豊力教授等。 圖一:與簡忠漢教授及連豊力教授合影 2、 與會心得 韓國最近在機器人相關學界及業界投入巨大的資源來發展,短短幾年內即獲得相當程度 之進展。下列圖二到四展示出會議中數種已商業化之機器人。 除此之外,在各項國際會 議中韓國學者亦有優異的表現。與會台灣學者均希望主管單位能多投注資源在這重要的 領域上面。除了一般演講外,幾個Keynote speakers 的演講均非常精彩。

圖二 圖三

圖四

![圖 5 手勢偵測結果:正確(上方三張圖),錯誤(下方三張圖) 在圖 6 中,展示了對於不同視角所拍攝到了同一個手勢的偵測結果,我們的所提出 的方法可以成功的在 40 度的旋轉角度內仍能成功偵測出結果。 圖 6 不同視角下的手勢偵測結果:(a)(f)無法偵測(b)(c)(d)(e)成功偵測 讀 者 可 在 [6] 獲 得 更 多 演 算 法 細 節 , 並 可 在 下 列 網 址 下 載 系 統 展 示 影 片 http://www.csie.ntu.edu.tw/~bobwang/videos/H](https://thumb-ap.123doks.com/thumbv2/9libinfo/8657946.194627/7.892.236.664.48.255/手勢偵三張圖能成功偵測出結果不同視角下的手勢結果下列網.webp)

![圖 7 復興南路與辛亥路口之移動物體追蹤 在圖 8 中,路口紅綠燈狀況應為左右通行,因此大部分的軌跡皆為左右方向,而上 下軌跡出現,即可判斷為不正常情形,此即為闖紅燈的狀況。 圖 8 不正常現象(闖紅燈)的偵測 讀 者 可 在 [5] 獲 得 更 多 演 算 法 細 節 , 並 可 在 下 列 網 址 下 載 系 統 展 示 影 片 http://www.csie.ntu.edu.tw/~bobwang/videos/InteractingObjectTracking.mpg](https://thumb-ap.123doks.com/thumbv2/9libinfo/8657946.194627/8.892.228.654.50.561/闖紅燈的狀況不正常現象闖紅燈的偵測者統展示影片.webp)