國立高雄大學資訊管理學系碩士班

碩士論文

無人飛行載具空拍影像目標物件即時自動辨識與定位

系統之研究

A Study of Unmanned Aerial Vehicle Real-time

Automatic Objects Identification and Positioning System

研究生:羅秋馨 撰

指導教授:蕭漢威 博士

無人飛行載具空拍影像目標物件即時自動辨識與定位

系統之研究

指導教授:蕭漢威 博士 國立高雄大學資訊管理研究所 學生:羅秋馨 國立高雄大學資訊管理研究所 摘要 近年來無人飛行載具核心技術快速進步且成本低廉,民用方面無人飛行載具 搭載攝影機在環境監測、航空測量等用途被廣泛運用。無人飛行載具因其良好的 機動性與視野可克服陸上的障礙物快速搜尋目標,在現階段一般操控上主要是以 手動模式操作,僅能在地面人員視線範圍內飛行或透過影像遠端遙控。進階搭載 全球衛星導航系統後操作模式有所轉變,無人飛行載具可以設定飛行路徑,使其 自動航行,擴展更多應用方式,例如大範圍區域自動監控環境與搜尋目標物,更 可利用自身的全球衛星導航系統座標定位目標物,因此搭載攝影裝置的無人飛行 載具也可被廣泛使用在救災與危險場域的探勘上。 在本研究中提出了可即時自動辨識搜索與定位目標物的架構,利用深度學習 技術建立辨識特定類別目標物的模型,以此模型搭載在無人飛行載具上。在飛行 的過程中,無人飛行載具的機載運算單元藉由物件辨識模型快速在即時影像中辨 識出目標物,並根據無人飛行載具的飛行姿態估算目標物的全球衛星導航系統座 標,綜合上述規劃出可自動辨識與定位目標物的系統,使無人飛行載具可在巡航 的同時回傳目標物即時座標,幫助地面人員快速判斷當前情況,在更短時間內做 出決策及行動。 關鍵字:空拍影像辨識、空拍物件定位、無人載具、深度學習A Study of Unmanned Aerial Vehicle Real-time

Automatic Objects Identification and Positioning

System

Advisor: Dr. Han-Wei Hsiao Department of Information Management

National University of Kaohsiung

Student: Chiu-Hsin Lo

Department of Information Management National University of Kaohsiung

ABSTRACT

Because of the improvement of core technologies and reduced cost, civil unmanned aerial vehicles (UAVs) with cameras have been utilized in different fields such as environment monitoring and aerial surveys. The great view and flexibility make UAVs not obstruct by obstacles on the ground, therefore, they can find targets in a short time. The typical method of operating a UAV is using the manual mode that requires it in the ground operator's view or remoting using video stream. An advanced method is letting the UAV automatically fly on a preset path using GNSS. This method allows various applications such as target searching and environment monitoring of a wider area. Furthermore, combining the automatic searching and target positioning features, UAVs could be used to disaster relief and prospecting.

We proposed a real-time object identification and positioning system which contained an object identification training process which trained an object identification model by Deep Learning to find the specific class of objects in a frame of a real-time video, and an object positioning process which calculated the relative position of the target with the location of the object in the frame and flight attitude to get the GNSS coordinate of the target immediately. With the object identification model and target positioning feature, UAVs can help ground crews make decisions in a short time by returning real-time coordinates of the target.

Keywords: Aerial Photograph Object Detection, Aerial Photograph Object

目錄

目錄 ... v 表目錄 ... vi 圖目錄 ... vii 第一章 緒論 ... 1 第一節 研究背景 ... 1 第二節 研究動機 ... 2 第三節 研究目的 ... 4 第二章 文獻探討 ... 5 第一節 無人飛行載具與電腦視覺之相關研究 ... 5 第二節 物件辨識的相關研究 ... 6 第三節 攝影測量的相關研究 ... 10 第三章 研究方法 ... 12 第一節 流程架構 ... 12 第二節 物件偵測訓練流程 ... 14 第三節 物件定位流程 ... 18 第四章 實驗與評估 ... 24 第一節 實驗環境與實驗方式 ... 24 第二節 實驗結果與評估 ... 33 第五章 結論與未來方向... 45 參考文獻 ... 48表目錄

表 1. 無人飛行載具搭載電腦視覺之應用 ... 5 表 2. 實驗用旋翼機之規格 ... 15 表 3. 實驗用攝影機之規格與使用的影像模式 ... 25 表 4. 不同高度實驗用攝影機對地面的地景攝影視野範圍 ... 27 表 5. 車輛 A 在影像辨識中被辨識出時擁有的信心程度 ... 36 表 6. 車輛 B 在影像辨識中被辨識出時擁有的信心程度 ... 36 表 7. 車輛 C 在影像辨識中被辨識出時擁有的信心程度 ... 37 表 8. 車輛 A 定位位置與實際目標 ... 38 表 9. 車輛 B 定位位置與實際目標 ... 39 表 10. 車輛 C 定位位置與實際目標 ... 39 表 11. 飛行高度 100 公尺車輛位置標準差與誤差 ... 40 表 12. 飛行高度 150 公尺車輛位置標準差與誤差 ... 40 表 13. 飛行高度 200 公尺車輛位置標準差與誤差 ... 41 表 14. 車輛各高度代表點間距離 ... 43圖目錄

圖 1. 深度學習與表徵學習、機器學習、人工智慧的關係 ... 7 圖 2. LeCun 於 1998 年提出 LeNet 之結構... 7 圖 3. 卷積運算示意圖 ... 8 圖 4. 周圍補上 0 的影像,同一局部以不同過濾器得到不同特徵值 ... 8 圖 5. 最大池化示意圖 ... 9 圖 6. 雙眼視野交疊產生立體視覺 ... 11 圖 7. 本研究之流程架構 ... 13 圖 8 十字與 X 字型旋翼機 ... 14 圖 9. 物件偵測的訓練流程 ... 16 圖 10. 為空拍圖中物件標定邊界框示意 ... 16 圖 11. 一場域空拍影像 ... 17 圖 12. 物件定位流程 ... 18 圖 13. 以為機頭前進方向為 Xf 軸建立座標系 ... 19 圖 14. 無人飛行載具姿態示意圖 ... 20 圖 15. 觀測點、像點與物點相對關係 ... 21 圖 16. 對地俯視所見之平面座標系 ... 22 圖 17. 以極座標表示 P 點 ... 23 圖 18. 實驗用攝影機在不同鏡頭模式下的攝影情形 ... 25 圖 19. 視野夾角、相機高度與視野涵蓋範圍之關係 ... 26 圖 20. 疊圖確認飛行路徑視野能否涵蓋目標物 ... 28 圖 21. 相機傾斜時拍攝的範圍 ... 29 圖 22. 重疊率 50 % 、30 % 以及影像未重疊之情形 ... 29 圖 23. K-medoids 說明示意 ... 32 圖 24. 空拍圖中的車輛 A ... 33 圖 25. 空拍圖中的車輛 B ... 34 圖 26. 空拍圖中的車輛 C ... 34第一章 緒論

無人飛行載具 (Unmanned Aerial Vehicle, UAV) 是泛指駕駛員不在機體內部 操作,只仰賴遙控或導航的飛行器,按其用途又可區分為軍用無人飛行載具 (Military UAVs) 以及民用飛行載具 (Civil UAVs) 。民用飛行載具近年因核心技 術進步且成本低,逐漸被廣泛應用在不同領域,又因無人飛行載具機動性良好, 能輕易深入惡劣的環境中,所以適合作為場域探勘的先發偵測應用。特別是近年 來地球暖化氣候變遷的原因,常有大規模的天然災害造成生命與財產重大的損失, 如何應用以無人飛行載具做為大範圍快速反應的防災應用己成為未來重要的研 究趨勢。在目前各方採用以人工判別空拍影像的方式,往往不利於大範圍長期的 空中攝影判讀,若是能自動化搜索與定位,使無人飛行載具在災害探勘過程中立 刻回傳目標地理位置,將可大大降低資料處理時間,使人員能更快速做好相應對 策縮短救援時間,以提供更有效率的災防應用。因此本研究欲提出由影像像空間 (Image Space) 中特定物件的座標對應至物件空間 (Object Space) 座標之方法, 透過載入深度學習預先訓練之模型,在無人飛行載具上分析即時 (Real-time) 空 拍影像,偵測物件在影像中的位置,偕同無人飛行載具姿態資料完成物空間中全 球衛星導航系統 (Global Navigation Satellite System, GNSS) 座標定位並傳回特 定物件位置資訊,以期縮短大範圍搜索的耗時。本章節將針對無人飛行載具在高 空如何定位目標,以及本研究架構的重要性分別進行說明。 第一節 研究背景 無人飛行載具從科學研究、國土測量、商業使用乃至個人空中攝影等應用開 始進入大眾視線。相比於訓練專人駕駛飛行載具達成追蹤、偵測、監控環境等目 的,無人飛行載具搭載各式偵測器與致動器 (Actuator) 能以低廉成本進行資料 蒐集、投放物件等任務,因此各領域陸續投入結合無人飛行載具應用之研究人員

與資金逐日增加。根據 GlobeNewswire 公司在 2019 年的報告[1]表示:在 2018 年無人飛行載具的市場規模產值為97 億,並且預期在 2015 年至 2026 年期間複 合年均成長率 (Compound Annual Growth Rate, CAGR) 為 12.54% 的條件下,在 2026 年無人飛行載具之市場規模將達到 274 億。市場調查諮詢企業 Mordor Intelligence 也認為在 2019 年至 2024 年期間市場規模產值之複合年均成長率將 大於10%[2],並且小型無人機市場規模之複合年均成長率更會超過 15%[3],隨 著小型無人機的市場規模將持續成長,在民用與商用領域上也逐漸受到重視。

近年來各國法規對於民用及商用無人飛行載具陸續新增與修訂不同法規,歐 盟航空安全局 (Aviation Safety Agency, EASA) 、美國聯邦航空總署 (Federal Aviation Administration, FAA) 、中國民用航空局 (Civil Aviation Administration of China) 以及我國交通部民用航空局 (Civil Aeronautics Administration, MOTC) 都 有提出相關規範與政策。這也意味著各國政府重視無人飛行載具在民用目的上的 發展,並且無人飛行載具相關技術與用途的發展是重要且持續的。 第二節 研究動機 本研究主要利用無人飛行載具良好的機動性、地域限制低等特點搭載小型攝 影機,在無人飛行載具上建構即時自動辨識及定位目標物件的系統。此系統應用 深度學習技術在空拍影像物件辨識上,預期可依不同搜索目的預先訓練對應的辨 識模型,在不同情境下針對特定類別目標進行搜索與定位,例如:海上漂浮物搜 尋、災害救援探勘、監測外來種植披在的山林分布情形等等。 以監測外來種植披的分布為目的時,監測的區域通常在山林之中且人煙稀少, 道路行進不易,加上山林中地形崎嶇,大量樹木遮蔽視野,難以在特定位置觀測, 因此在探勘及記錄的過程勢必耗費大量時間。在上述視野受到侷限,並且地面行 動受到侷限的條件下,若是利用無人機在上空的視野及機動性,自動辨識並定位 外來種植披中心位置,就能快速分析其在地理環境的位置與範圍並縮短資料蒐集

處理目標植披,克服陸上視野與行動受限的問題。

在傳統的物件偵測定位上,經常使用雷達 (Radio Detection and Ranging, RADAR) 定向發射電磁波,並藉由物體反射得知物體位置及形狀完成物件偵測 與定位。使用傳統雷達雖然可以在範圍內偵測及定位物件,但由於雷達僅能取得 物件外型,難以再就顏色、大小等特徵判斷物體種類,因此想利用其定位能力搜 尋森林火災火源處、原始地貌是否遭受濫墾、濫伐等並且定位有其侷限性。而利 用空拍影像進行自動辨識與定位,就能以更多特徵判定目標物件種類並且快速定 位,若是搭載紅外線攝影機在視線不佳的夜晚也能在危險的野外進行勘查。 以往無人飛行載具搜尋目標物及定位需要機體接近目標物,再回傳自身地理 位置以定位單一目標物,並前往下一目標物進行定位。然而上述的程序在接近火 源或爆裂物等危險目標物時可能會有損毀的風險。以森林發生火災而言,在無人 飛行載具上搭載自動辨識與定位系統,將可在遠處辨識出目標物,並且定位回傳 資訊給地面站。如此一來不僅能讓機體不須接近目標物便可搜尋與定位,更可以 在短時間內搜索多個目標物,還免除了無人飛行載具飛行至目標物的航程,充分 展現出在搜索目標物時的安全性以及即時性。2012 年我國台北市政府工務局在 施政報告首度提出使用無人飛行載具管理山坡地協助違規查證[4],並在近年的 施政報告指出在無人飛行載具及其他技術偕同下成功取締違規業者[5]。無人飛 行載具不須接近目標物也能在遠處監視,可在盜伐、濫墾者視線外迅速發現目標 彌補人力的不足,若是搭載自動辨識與定位比起單純在地面監視與分析空拍影像 能更快速決策前往現場制止濫墾及取締,阻止土地受到更多損害。 無人飛行載具在搜索上能突破環境的限制,配合攝影機能同時擁有良好的機 動性與視野,可降低搜索目標時需要的人力成本。結合自動辨識與定位可使無人 飛行載具搜索目標物時具有即時性,大幅減少同時搜尋多個目標所需的時間,透 過在航行過程中即時定位目標物,協助地面人員減少在地面需要閱讀的資訊,加 速分析、判斷到決策行動間的需時。本研究中在無人飛行載具硬體及系統的配置 上具有一定彈性,攝影機與物件辨識模型皆可因應不同應用需求做合適的替換,

更可增加不同種類與目的致動器,因此預期在本研究中提出的系統可衍生出多種 應用,在不同領域中實現快速搜索,同時降低時間、金錢與人力成本。 第三節 研究目的 基於無人飛行載具搭載攝影機可同時擁有良好的機動性與視野等優勢,本研 究預期建構針對空拍目標物即時自動辨識與定位的系統,該系統將被搭載在無人 飛行載具上,對飛行時所得的即時空拍影像與飛行姿態資料進行運算分析,得出 目標物當下的位置資訊。本研究中所提出的系統中主要包含物件辨識模型以及依 據 高 空 圖 像 定 位 目 標 物 的 方 法 。 首 先 物 件 辨 識 模 型 使 用 卷 積 神 經 網 路 (Convolutional Neural Network, CNN) 及大量空拍圖訓練具可用性之模型,用以 辨識得到影像中目標物件所在位置,其次根據圖像上之位置資訊以及感測器在無 人飛行載具上取得的飛行姿態資料、全球衛星導航系統座標,利用攝影測量法從 空拍影像標定目標物在物空間時的地理位置,使得無人載具可在取得高空影像的 同時完成自動辨識與定位目標物件,最後透過網路立即回傳目標物之辨識資訊與 定位資訊。

第二章 文獻探討

無人飛行載具可搭載非測量型攝影機,在場域內利用電腦視覺方法搜尋與定 位目標物,在本研究中主要使用物件辨識與攝影測量相關技術在航行過程即時自 動辨識物件與定位物件。無人飛行載具因牽涉負重因素,可搭載的運算資源與攝 影設備種類有限,想在空中實現即時辨識、定位物件是項嚴峻的挑戰,未來也還 有許多發展空間,因此本章將針對物件辨識與攝影測量的相關研究進行探討。 第一節 無人飛行載具與電腦視覺之相關研究 電腦視覺影像辨識的領域裡,深度學習 (Deep Learning) 一重要的技術,深 度學習在不同領域早已有多種應用,醫學上能提升乳腺癌篩檢的速度及準確性 [6]、食安管理中挑選出有問題的食材[7]、生活中停車場閘門車牌辨識等等各處 都有其蹤跡。伴隨著深度學習影像辨識相關技術臻至成熟,電腦視覺與人工智能 相關技術導入無人飛行載具領域的應用隨之發展。在商用與科學研究中已發展諸 多無人飛行載具與電腦視覺之應用,如表 1 所示。 表 1. 無人飛行載具搭載電腦視覺之應用 用途 實例 環境監測 都市計畫 災害應對 娛樂用途 農地監控[8]、野生動物數 量監控[9] 國土測量[10]、掃描危險 建築[11] 災情調查、物資運送[12] 空拍機追蹤拍攝對象 在環境監控的應用上,烏克蘭公司 Agrieye 以無人飛行載具巡田取得影像[8],自動偵測有問題的區域進一步分析土壤成分,輔助農夫種植作物的決策。另 外也有學者在非洲以無人飛行載具搭載攝影機,應用電腦視覺相關技術辨識區域 內之野生動物以便監控數量,研究員既不需費時深入野地,也能避開被野生動物 攻擊的風險。我國內政部國土測繪中心自民國九十七年起測試非測量型相機於航 空攝影上之可行性[10],並認為可被用於國土規畫管理、救災防災領域以及民生 建設。近代高樓林立,摩天建築因應商業辦公、觀景、展現建築工藝需求而生, 在動輒上百公尺的高度下,使用無人機探查與維護摩天建築外部,將大幅減少建 築工人探勘的危險以及時間[11]。在無人機搭載電腦視覺技術發展成熟後,相關 商業產品成本降低容易取得,甚至也發展出空中追蹤攝影目標物等娛樂用途。 第二節 物件辨識的相關研究 針對要搭載在無人飛行載具上的物件辨識架構,首先要考慮無人飛行載具位 置會不斷更動且目標物可能移動,使得無人飛行載具航行的過程中必須不斷更新 目標物的位置與飛行姿態資訊,在高空中不斷蒐集動態影像。再者要考量無人飛 行載具載重能力有限,無法搭載具被高度運算能力之主機。因此必須挑選一個擁 有在短時間內分析大量影像的能力且運算負擔輕量的物件偵測方法。近年來圖像 物件偵測使用的方法以深度學習為主流,如圖 1 所示,深度學習為人工智慧領 域內機器學習與表徵學習中的一分支,除卻繼承了機器學習的特徵映射 (Feature Mapping) 在學習過程產生特徵資料,為提升準確性額外增加多個抽性特徵層級 模擬人腦分析事物的方式。深度學習廣泛所知被可運用於電腦視覺、自然語言處 理、機器人相關技術、生物資訊、搜尋引擎與遊戲等領域,本節將探討深度學習 應用在物件辨識時常見的結構。

圖 1. 深度學習與表徵學習、機器學習、人工智慧的關係[13]

深度學習以人工神經網路 (Artificial Neural Network,ANN) 為基礎,可以用 來學習大量資料,人工神經網路是模仿生物神經網路的結構建立而成,藉由似神 經元的人工節點互相連結,用權重調整節點間的連結強度,透過函數運算判斷決 策,使得人工神經網路能像生物神經網路一樣透過學習與訓練得到決策能力。卷 積神經網路是人工神經網路的其中一種,常被用在影像辨識相關的系統上。卷積 神經網路的架構源自 LeCun 1998 提出的 LeNet[14],如圖 2 所描述,卷積神經 網路架構主要由卷積層 (Convolution Layer) 、採樣 / 池化層 (Subsampling/ Pooling Layer) 、全連接層 (Fully Connective Layer) 構成。

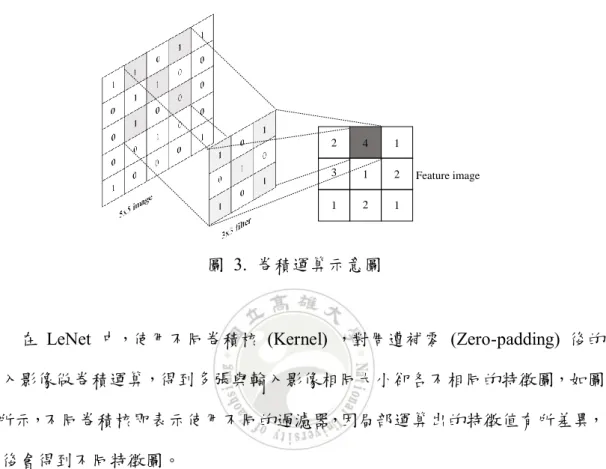

圖 2. LeCun 於 1998 年提出 LeNet 之結構[14] 典型的卷積神經網路在卷積層與池化層萃取影像特徵,卷積層利用過濾器 (filter) 做卷積運算,萃取出特徵圖,如圖 3 所示意,左側是 5 x 5 的影像,中間 為一個3 x 3 的過濾器,過濾器的對角值皆為 1 用以遮罩原始圖像當中一個 3 x 3 的區塊,將此區塊內被遮罩的部分的值相加,以圖3 而言被遮罩的對角線存在 4 AI Machine Learning Representation learning Deep Learning

個1 與 1 個 0,相加後得到 4,此時 4 變為這個區域內的特徵值,並寫入特徵影 像的相對像素內,經多次移動遮罩取得不同局部特徵值反覆紀錄後,即可得到圖 3 右側之特徵圖。

圖 3. 卷積運算示意圖

在 LeNet 中,使用不同卷積核 (Kernel) ,對周遭補零 (Zero-padding) 後的 輸入影像做卷積運算,得到多張與輸入影像相同大小卻各不相同的特徵圖,如圖 4 所示,不同卷積核即表示使用不同的過濾器,因局部運算出的特徵值有所差異, 最後會得到不同特徵圖。 圖 4. 周圍補上 0 的影像,同一局部以不同過濾器得到不同特徵值 2 1 1 1 1 4 2 3 2 Feature image

池化層中使用最大池化 (Max Pooling) 對特徵圖進行運算如圖 5 所示,將 原本特徵圖中設置一個邊長為2 x 2 的窗口,在並在其中萃取最大值填入池化後 圖片的對應位置,在反覆移動窗口取得各局部的最大值後,最後會產出只有原圖 四分之一像素的新特徵圖,池化可以避免學習圖片中不必要的雜訊,導致過度學 習導致只能對已知的影像資料判斷精確,卻無法預測新的影像資料內容。在反覆 經過卷積與池化過程後,最後全連結層使處理過後的特徵結合權重對輸入的影像 進行分類,經過數次的訓練與測試評估當前辨識的遺失率,直到遺失率足夠低或 以更多指標判斷能採用整個模型用來物件識別。 圖 5. 最大池化示意圖 隨著卷積神經網路在 2012 年[15] AlexNet 發表後開始被重視,區域卷積神 經 網 路 (Region-based CNN, CNN)[16] 、快 速 區 域卷 積神 經 網路 (Fast R-CNN)[17]等物件偵測方法相繼於 2014、2015 年被提出,區域卷積神經網路的架 構是基於卷積神經網路,但在使用卷積神經網路計算特徵之前會先將影像利用局 部的大小、紋理、形狀等先行計算區域相似度提出2000 至 3000 個候選區 (Region proposal) ,並將候選區影像調整為相同大小影像後作為卷積神經網路的輸入。使 用卷積神經網路提取特徵後,區域卷機神經網路使用支援向量機 (Support Vector Machine, SVM)區分候選區將其分類,最後使用線性回歸模型找出邊界框合適的 位置,提升物件類別判別與物件邊界的準確性。由於區域卷積神經網路將所有候 選區圖像都做為輸入資料會產生大量重複計算的問題,因此快速區域卷積神經網 路為了縮短辨識時間被提出,只是這還不足以解決即時影像辨識的問題。 2 1 5 1 1 4 2 3 4 1 1 2 1 1 3 2 4 5 4 3 Feature image

2015 年 Redmon[18]等人提出 YOLO 演算法, YOLO 使用卷積神經網路 辨識影像物件,不同於區域卷積神經網路與快速區域卷積神經網路,YOLO 不使 用候選區與回歸等方法辨識物件與分類,僅以原始影像資料透過卷積神經網路得 到最終分類結果,節省物件辨識的時間,實現即時影像物件辨識,而2017 年 Wu 等 學 者[19] 也 以 即 時 物 件 偵 測 為 目 的 優 化 全 卷 積 網 路 (Fully Convolutional Networks, FCN) 提出 SqueezeDet ,前兩者提出的方法皆簡化了運算步驟,平衡 了即時物件偵測所需要的正確性與即時性,減輕系統的運算負擔。即時物件偵測 除了維持一定水平的正確性外,幀率與減輕運算負擔成為了更重要的目標。近年 來, YOLO 演算法對於空拍影像物件辨識的相關研究也陸續出現,例如辨識空 拍影像中的鳥類[20]、車輛[21]以及海上船隻[22],因此本研究預期使用此演算法 可以協助即時辨識空拍影像內的特定物件,並且本研究應用 YOLO 演算法作為 即時影像物件辨識之用,。 第三節 攝影測量的相關研究 動物的視覺系統[23]偵測物體如圖 6 所示,動物利用雙眼視野交疊產生立體 視覺 (Binocular vision) ,藉著有景深的影像使動物能判斷目標物的距離。2000 年Murray 與 Little[24]將立體視覺運用在移動機器人的導航,另外有 Bertozzi 等 學者[25]2010 年將立體視覺系統應用在自動駕駛車輛上,讓其定位與追蹤附近的 車輛維持本身自動駕駛的安全性。電腦視覺通常利用兩攝影機取代雙眼模擬雙眼 立體視覺,常見於自主式機器人 (Autonomous Mobile Robots, AMR) 和自動駕駛 車輛 (Automatic Vehicle Driving) 的應用上。

圖 6. 雙眼視野交疊產生立體視覺 在地面上,自動駕駛車輛與自主式機器人使用立體視覺估算障礙物或目標物 距離,並有高度即時性。在無人飛行載具因為載重有限,必須減輕重量,難以搭 載雙鏡頭或攝影機,與自動駕駛車輛和自主式機器人的近距離攝影[26]不同,無 人飛行載具在高空對地面進行攝影,距離物件至少數十公尺,因此需要不同的方 法計算目標物距離。共線條件方程式 (Collinearity equation) 常被應用在遙測 (Remoting Sensing) 與航空攝影測量中[27],利用光線直進的原理,透視投影中心、 像點與物點必須在同一直線上的特徵發展定位方式。本研究在物件定位上中也以 光線直進作為基礎理論,但使用三角函數運算與極座標轉換運用在攝影測量,使 得系統可透過拍攝的高空影像定位目標物的全球衛星導航系統座標。

第三章 研究方法

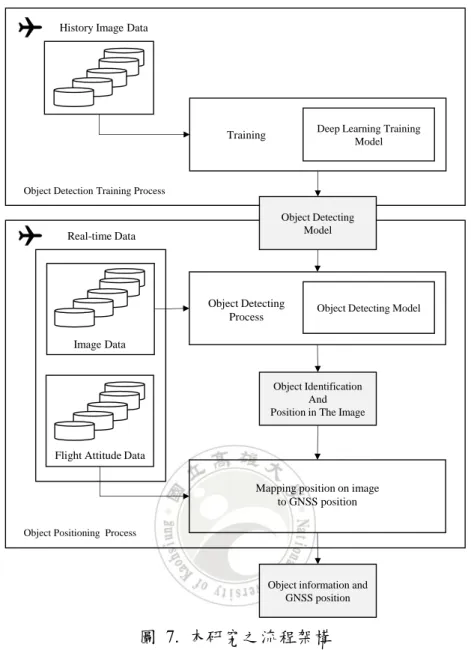

本研究將針對無人飛行載具大範圍場域之中搜索特定類別的目標物進行研 究,且此類目標物在場域中位置未知,本研究欲在空對地搜索過程中即時辨認物 體及定位,快速提供目標物件全球衛星導航系統座標位置供接收端使用,達成縮 短制定策略前所需的搜索及分析時間。在研究中,主要會將預訓練完成之深度學 習模型搭載在無人飛行載具控制系統上,飛行過程中以攝影機拍攝對地影像,經 由深度學習已事前訓練完成辨識模型,即時判斷影像中的特定物件,再根據拍攝 時無人飛行載具所在地座標,以及飛行姿態判斷此目標物件在物空間中之實際位 置,並分析得出全球衛星導航系統座標傳回接收端。首先會在第一節中說明本研 究中之架構,此架構可以應用在不同類型無人飛行載具上,而再後續章節中將針 對第一節所提出的架構分段說明。 第一節 流程架構 在本研究中預期由高空拍攝影像即時定位特定類別物件座標,因此將利用深 度學習訓練物件辨識模型搭載於無人飛行載具,輸出物件於空拍影像的座標,並 結合飛行姿態資訊以三角函數及極座標等數學來計算出所辨識物件之全球衛星 導航系統座標,即物件在物空間位置。 本研究之流程架構如圖 7 所示,將流程依序分割成物件偵測訓練流程 (Object Detection Training Process) , 再 是 物 件 定 位 流 程 (Object Positioning Process) 。物件定位流程中將使用物件偵測訓練流程所產出的物件偵測模型,藉 此完成特定類別物件之搜尋與定位。圖 7. 本研究之流程架構 在物件偵測訓練流程中,首先蒐集大量空拍影像,並且對每張空拍圖中之特 定類別物件進行標定,之後利用卷積神經網路針對歷史空拍影像進行大量訓練, 將由此所得到的物件偵測模型供下一個流程使用。而在物件定位流程中,無人飛 行載具會在飛行時同時攝影,並得到即時影像資料與飛行姿態資料,即時影像資 料以偵測模型分析後可得到物件在影像空間中的位置。配合即時飛行姿態資料與 物件在影像空間中的座標,經過計算可對應到目標在物空間中與無人飛行載具的 相對位置,最後根據無人飛行載具的全球衛星導航系統座標定位出物件的全球衛 星導航系統座標並且傳回給地面接收端。 Object Detecting Model

Deep Learning Training Model Training

Object Detecting Process History Image Data

Real-time Data

Image Data

Flight Attitude Data

Object Identification And Position in The Image

Mapping position on image to GNSS position Object Detection Training Process

Object Positioning Process

Object information and GNSS position

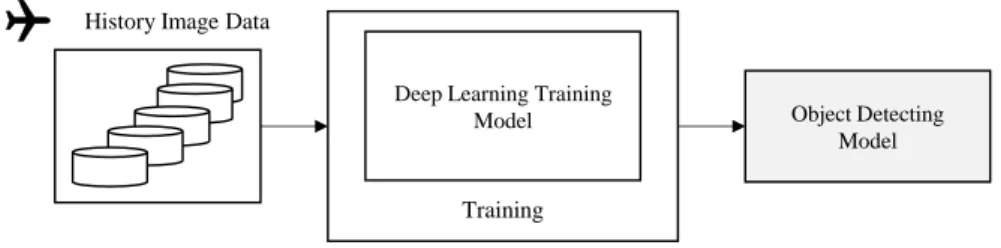

第二節 物件偵測訓練流程 無人飛行載具主要可分為撲翼機、定翼機與旋翼機,撲翼機的飛行與推進方 式是模仿鳥類拍動翅膀飛行的行為,但目前撲翼機在我們的日常當中難以被當作 商品量產,因此不考慮在本研究中使用撲翼機。定翼機與旋翼機在日常生活中則 較為常見:定翼機的機身使用固定的機翼提供升力飛行,像是常見的飛機、戰鬥 機、滑翔翼都可歸類在定翼機;旋翼機的機身裝有一個或多個的旋翼,利用旋翼 與空氣間的相對運動產生升力使機體上升,直升機與四軸飛行器皆屬旋翼機。定 翼機與旋翼機相比之下,轉彎時機身需要傾斜,並且機頭方向始終與飛行方向相 同,而旋翼機轉彎則可以整體機身不調轉方向,可以橫向移動或後退移動,搜集 影像資料時容易調整或固定拍攝方向,因此本研究在定翼機與旋翼機之間選擇旋 翼機做為在高空蒐集影像的飛行載具,旋翼機依飛行前進方向如圖 8 又可分為 十字型與 X 型的旋翼機,本研究中所使用的旋翼機為 X 型的旋翼機。 (a) 十字型旋翼機 (b) X 字型旋翼機 圖 8 十字與 X 字型旋翼機 本研究中使用的旋翼機規格如下表 2 所示,旋翼機之機架大小,也就是機 體本身的對角線長度為 550 公釐,上面配備四組無刷馬達及槳,槳會如同竹蜻 蜓轉動葉片產生向下的強風產生向上的升力,在四組槳互相配合轉動時將提供旋 翼機升力飛行,槳需要靠無刷馬達帶動旋轉,馬達本身的功率與最大轉速相關, 也影響槳能夠提供的升力大小。本研究中使用的槳的大小皆為 14 吋,而馬達大

電池、相機等配備足夠的升力。在本研究中旋翼機供電使用鋰聚合物電池,電壓 為11.1 伏特、容量為 5200 毫安培小時 (mAH) 能支撐在本實驗完成整趟特定高 度下對選定場域的飛行。在飛行控制上本研究使用 Pixhawk 飛控板搭配飛控軟 體 ArduCopter (APM:Copter) V3.2.1, 控制旋翼機飛行模式與飛行路徑來拍攝特 定場域之影像,作為物件偵測流程中使用的即時影像資料。 表 2. 實驗用旋翼機之規格 機架大小 (對角線長度) 550 mm 電池 11.1 V – 5200 mAH 鋰聚合物電池 馬達 類別 無刷馬達 直徑 31 mm 高度 8 mm 最大功率 300w (四顆) 槳 14 吋 飛行控制系統 Pixhawk 飛控板、 ArduCopter (APM:Copter) V3.2.1 飛控軟體 重量 1700 g 若要取得即時影像上某類別物件的座標,必須能夠從圖像上辨識該類別之物 件,為此必須訓練物件偵測模型,在本研究中將利用卷積神經網路訓練物件辨識 模型。物件偵測訓練流程如下圖 9 所示。

圖 9. 物件偵測的訓練流程 在此流程中,首先以無人飛行載具在一場域內飛行並且拍攝高空影像資料, 以此作為歷史空拍影像,並且將高空影像分為兩圖像集,一圖像集作為訓練之用, 另一則用以測試模型是否收斂符合需求。圖 10 為標記邊界框之示意,將物件標 示出邊界,標記足夠數量的圖像後迭代訓練,最後可得到卷積網路合適的權重, 完成不同類別物件偵測模型。該場域存在不同類別物件,其中以屋頂、建築物側 面、一般車輛、卡車、樹木、操場為大宗,訓練時將多類的物件標記進行訓練。 以圖 10、圖 11 所在場域為例,使用經訓練後模型來偵測圖 11 (a) 當中是否存 在上述所需辨別的類別物件,得圖 11 (b) 的結果,在圖 11 (b) 高空影像中可見 到被偵測的物件被標記邊界與標籤。 圖 10. 為空拍圖中物件標定邊界框示意

Deep Learning Training Model

Training History Image Data

Object Detecting Model

(a) 原始空拍影像 (b) 物件偵測標籤後的影像

圖 11. 一場域空拍影像

在本研究中,會將區域內常見空拍偵測物件區分為不同類別,以上圖為例, 分別有車輛 (Car) 、卡車 (Truck) 、建築物 (Building) 、屋頂 (Roof) 、樹木 (Tree) 與操場 (Playground) ,以多項分類做為偵測的目標類別。因無人飛行載具拍攝視 角差異,將房屋細分成能看到側面的建築物類別,與只能看到屋頂的屋頂類別, 避免混淆。此模型可成功判別圖像上的物件類別,並且可在影片對每幀影像進行 物件辨識。透過物件偵測訓練流程得出可用的物件偵測模型,以此模型搭載於無 人飛行載具上分析在飛行時所攝之影像,便可偵測各類別的目標物件位置,可同 即時飛行姿態資訊一起供下一步分析使用。

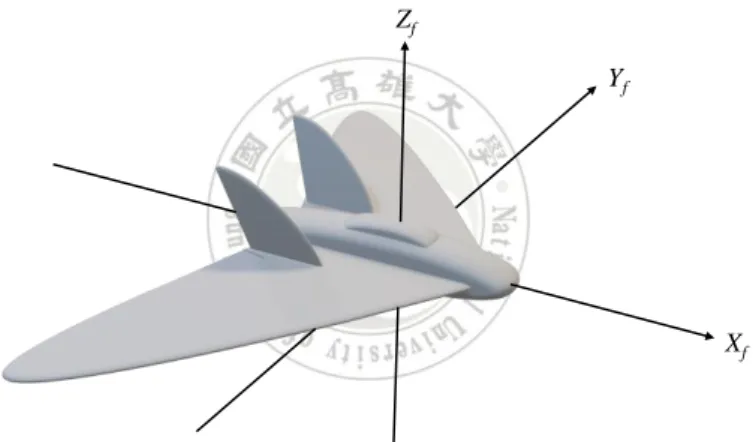

第三節 物件定位流程 在本研究中,無人飛行載具將搭載非量測型攝影機,在行進期間持續取得即 時影像與飛行姿態資料。無人飛行載具系統內載入物件偵測訓練流程生成之模型, 可辨識即時影像中目標物件,並且在影像平面空間中定位該目標位置,由此開始 物件定位程序,如圖 12 所示。 圖 12. 物件定位流程 無人飛行載具會於飛行過程中會不斷蒐集即時影像資料與即時姿態資料,即 時影像資料透過物件偵測模型將判斷物件類別,並且輸出目標物件在影像上的座 標。而即時飛行姿態資料中則包含了對地高度、翻滾角 (Roll)、俯仰角 (Pitch)、 偏航角 (Yaw) 與全球衛星導航系統座標等資訊。 配合本研究所使用之飛行姿態感測器,機頭方向作為 Xf 軸,建立以機身中 心為原點的三維座標系,如圖 13 所示。(雖本研究實驗中是使用旋翼機,但因旋 翼機以圖說明較難辨別機頭方向,因此在以下示意圖中皆以定翼機圖像說明)由 Object Detecting Model Object Detecting Process Real-time Data Image Data

Flight Attitude Data

Object Identification And Position in The Image

Mapping position on image to GNSS position

Object information and GNSS position

圖 14 (a) 中可看到俯仰角是指機身以 Yf 軸為軸心,機頭向上或向下擺動與水平 平面形成夾角。機頭上仰時俯仰角由0 度開始正向增加角度,介於 0 度與 180 度 之間,俯身則由零度開始隨傾斜增加而角度遞減,並且角度介於0 度到 180 度。 圖 14 (b) 中則以 Xf 軸為軸心傾斜機身,而傾斜的機身與水平面夾角為翻滾角, 以水平姿態作為基準0 度,若由機尾看向機頭的方向,見機身順時鐘傾斜,此時 翻滾角隨傾斜程度增加,角度可介於0 度到 180 度之間,逆時鐘傾斜則反之,隨 傾斜增加而角度由0 度遞減,最多遞減至-180 度。圖 14 (c) 中則可直覺看出偏 航角是指以 Zf 為軸心,機頭與正北方的夾角,正北方作為偏航角 0 度,順時鐘 旋轉增加角度,偏航角的值會介於0 度至 360 度之間。 圖 13. 以為機頭前進方向為 Xf 軸建立座標系 (a) 俯仰角 Xf Yf Zf Xf Zf

(b) 翻滾角 (c) 偏航角 圖 14. 無人飛行載具姿態示意圖 在本研究中以機頭方向為拍攝影像的前方,攝影機被固定在機身,因此當機 身俯仰或傾斜時,在偏航角與物空間位置相同情況下所攝之影像,會隨傾斜角度 有程度不一的歪斜,因此不可直接使用所攝之影像旋轉偏航角後按高度比例縮放 取得影像中目標物實際上之全球衛星導航系統座標,必須先利用攝影方法中光線 直進之特性,由影像中的像點配合無人飛行載具感測器測得之翻滾角與俯仰角,

Z

fY

f 機尾X

fY

fN

置。 在三維空間座標系中,可將一向量分解成三個正交的向量,因此可將問題的 維度降低討論,以定位地面目標物而言,僅須利用現有資料計算出在水平面上的 座標關係即可,不需要計算物件之高度,在討論俯仰角與翻滾角時皆可省略對目 標高度的計算。已知俯仰角以 Yf 軸為軸心轉動,因此在翻滾角固定的情形下, 無人載具之俯仰僅影響像點在傾斜平面上 Xf 座標的變化,反之亦然,翻滾角也 只會影響點在傾斜平面上 Yf 座標的變化,所以可將翻滾角與俯仰角一併討論。 探討俯仰角對像點與物點關係時,可僅討論俯仰角變化對單一軸座標的影響, 圖 15 所示為無人飛行載具位置、像點位置、目標物地面位置相對的關係,希望 能透過像點 t 在影像 Xf 軸上的座標,找出無人飛行載具垂直對地位置 OT 對當 下目標物 T 在一個維度上的向量。因有感測器所蒐集到的無人飛行載具對 T 所在平面的高度 hT ,若能求得圖形中之角度 θ ,就能利用正切在三角型 OTPT 中計算其對邊向量,而要找出 θ 為何,得先得知夾角 φ 與 τ 。 圖 15. 觀測點、像點與物點相對關係 圖 15 中可見位於 P 點的無人飛行載具機頭向上傾斜一角度,感測器可測 得的已知角度,俯仰角為 φ 時,攝影機隨之傾斜,得到成像平面將與水平方向 xf L t T θ φ O Ot P τ hT OT W φ

有一夾角,與俯仰角的角度相同。線段 Ot P 是為像距,像距的長度為 L,像距 長度與相機本身有關,同一相機的同一攝影模式及鏡頭下會有相同的像距,對 Xf 而言,Ot P 線段會與其交於點 Ot ,是影像的中心,並且線段 Ot P 與 軸 Xf 垂 直。在 Xf 軸所在平面有一點 t ,是地面上目標物 T 在影像上所成的像,並且 Xf 座標為 m 。在圖 15 中無人飛行載具與相機所在位置 P 點與影像中心 Ot 和像點 t 形成一直角三角型,並且已知像距為 L 與點 t 之座標 m ,因此可由 此三角型中利用反正切函數得到夾角 τ 。有了夾角 φ 與 τ 後,相加便能求得夾 角θ,推算出 T 點在地面上一個維度中的位置 M 。 透過翻滾角與俯仰角計算像點位置,以無人飛行載具垂直對地面的點為平面 座標系中心,機頭所朝方向為 X’ 軸正向,可得目標點 Q 的座標,如圖 16 所 示,且得知點 Q 在 X’ 與 Y’ 的分量為 (u, -v) ,此向量與 X’ 有一夾角 α , 可由反正切函數求得。 圖 16. 對地俯視所見之平面座標系 在本研究中,接下來的目的是將此點向量由 X’ 與 Y’ 之分量,利用已知 的偏航角,轉換成北向與西向之分量,因正北的偏航角為0 度,在飛行載具偏 航角為0 度的情形下,其本身坐標系中的 X 軸會指向北方, Y 軸會指向西 方,因此可以其作為基準使用機身地面位置座標系中點 Q 的 X’ 與 Y’ 的分 量,計算目標物對北與西的分量,如圖 17 所示。 X’ Q (u, -v) Y’ v α u

圖 17. 以極座標表示 P 點 在圖 17 中機頭方向 X’ 軸與正北 N 軸夾一篇航角 β ,若要計算原點對 點 Q 轉換成正北與正西的分量,可應用極座標系求得新座標。已知 Q 點座標 為 (u, -v) ,由畢氏定理可求得 r 之長度,使得 Q 點在 X’Y’ 座標系中可被表 示為 (r, 2π-α) ,在 X 軸對應正北的座標系中同一點 Q 則可被表示為 (r, 1.5 π+ γ) ,只要求出 1.5 π+ γ 的角度為何便可以得到點 Q 的新座標。在圖 17 中可看 出兩極個極座標的角度的差為無人飛行載具的偏航角,可推論出以下關係式 (1) ,將已知的偏航角 β 與先前所求出的 α 代入式 (1) 後,即可得出 Q 點新 的極座標,最後將 Q 點之極座標轉換為直角座標,即可得到 Q 點對北方向與 對西方向的分量。 1.5 π+ γ= 2 π- α- β 以極座標與直角座標轉換取得對目標物向西與向北的分量後,以台灣而言, 需將向西之向量單位由公尺轉換為東經的度數向量,向北之向量單位由公尺轉換 為北緯的度數向量,且因已知無人飛行載具當下之經緯度,以無人飛行載具的全 球衛星導航系統座標加上轉換單位後的向量,便可取得目標物所在的全球衛星導 航系統座標。 X’ N Q (r, 360 - α) φ Y’ v m β α u γ r (1)

第四章 實驗與評估

在本章當中會依前述流程架構進行物件偵測與物件定位實驗,在物件偵測流 程中,將探討從特定高度蒐集來的空拍圖訓練後的模型,是否在不同高度下的辨 識準確性有所差異。物件定位流程著重於定為目標物件一致性的精準性,如無人 飛行載具在不同觀測位置對同一目標物位置計算結果是否穩定、計算而得的位置 與真正目標位置偏移多寡。本章中透過無人飛行載具實際蒐集空拍影像及飛行姿 態資料進行實驗,分別驗證兩個流程的結果。以下將分兩個部分闡述實驗與其結 果之評估,第一部分為本實驗中的實驗環境以及實驗方法,第二部分則將以物件 偵測模型之準確性及目標物座標定位誤差評估實驗結果。 第一節 實驗環境與實驗方式 本實驗利用小型無人飛行載具於國立高雄大學上空飛行,以校園場域中之特 定建築、操場與車輛作為目標物進行實驗,分別選定管理學院、法學院、圖資大 樓、行政大樓、人文社會學院以及宿舍做為主要攝影區域實地飛行拍攝,透過相 機蒐集可用的影像資料。蒐集影像所使用的相機型號為 GoPro Hero8 Black ,相機規格與本實驗中所 使用的解析度模式和檔案格式如表 3 所示,該相機之影像最大解析度可達 4K, 可錄製長4000 像素且寬 3000 像素的影像,實驗用相機的 4K 錄影模式支援 16 : 9 與 4 : 3 兩種長寬比,本研究中使用該相機錄製 4K 影像,挑選長寬比 4 : 3 的 模式,使得高空影像畫面中能涵蓋較多地面範圍,地面物件足夠清晰,此模式下 攝影的幀數30 fps (frame per second),有足夠的幀數做即時影像辨識。影像支援 的格式為 MP4 , MP4 是一種破壞性資料壓縮 (lossy compression) ,因影音檔 案的壓縮率高使得檔案較小方便儲存,卻會有影像上的失真,本實驗中選擇H265 / HEVC 的編碼,可以使 MP4 影像壓縮率高,使用檔案時失真較少。而考慮到 旋翼機載重情形,攝影機的選擇應偏向小而輕巧,實驗用攝影機長、高與厚度,

分別為66.3 mm x 48.6 x 28.4 mm,重量包含電池僅有 126 g,架設在小型無人飛 行載具上對乘載空間及重量的要求不高,因此本選擇此相機作為本研究蒐集空拍 影像的工具。 表 3. 實驗用攝影機之規格與使用的影像模式 影像解析度 4K 4 : 3 - 30 FPS 錄影影像編碼方式 MP4 (H.265 / HEVC) 體積 66.3 mm x 48.6 mm x 28.4 mm 重量 126 公克 ( 含電池 ) 為避免影像失真及影像周圍型變,在攝影機數位鏡頭 (digital lens) 的選擇上 本研究使用線性 (linear) 數位鏡頭,圖 18 是三種常見數位鏡頭的模式在與物件 相同距離下所拍攝出的影像,從左至右分別使用廣角 (wide) 鏡頭、線性與窄角 (narrow) 鏡頭,當中三圖皆以本實驗用之攝影機所攝,並且以黑白相間的紙作為 攝影目標,從三張圖片的比較可明顯看出使用廣角鏡頭在圖像會有型變,線性鏡 頭相對於原始目標失真較少,圖片四周也幾乎沒有型變。窄角雖沒什麼型變,但 涵蓋範圍較線性小,因此本研究在實驗中的數位鏡頭挑選了線性模式。 (a) 廣角模式 (b) 線性模式 (c) 窄角模式 圖 18. 實驗用攝影機在不同鏡頭模式下的攝影情形 本研究搜集空拍圖不採用防手震,這是為了避免飛機姿態資料與空拍圖的傾 斜狀況在同一時間產生誤差。另外在規劃飛行拍攝路徑前必須先考慮在特定高度 下相機視野對地的涵蓋範圍,以確認蒐集空拍圖時能將目標物包含在拍攝影像當

中。本研究空拍時長寬比採4 : 3,在長寬比為 4 : 3 情形下從官方數據得知影像 之視野 (FOV, field of view) 夾角,垂直、水平與對角線夾角分別為 70.0 度、86.0 度、98.7 度,焦距為 19 公釐[28],可根據以上數據與旋翼機飛行高度求得視野 範圍決定飛行路徑。 圖 19 (a) 可見一相機由高空對地攝影,令 α 為其寬邊視野夾角, d 為相 機焦點對目標之距離,視野範圍寬度 w 未知。為方便推導求出視野範圍的式子, 可將圖 19 (a) 拆分簡化成一夾角為 α / 2 的直角三角形如圖 19 (b) 。 (a) 視野夾角與涵蓋範圍 (b) 以三角型夾角、高度推算涵蓋範圍 圖 19. 視野夾角、相機高度與視野涵蓋範圍之關係 藉由三角函數從已知視野夾角 α 及相機焦點對目標物距離 d 推得視野範 圍 w 如式 (2) 所示,又因相機之焦距僅 19 公釐,可忽略不計,可逕將已知之 α/2 α/2 d w α/2 w/2 d

垂直及水平視野夾角代入式 (2) 中,再代入旋翼機飛行拍攝高度,即可得到垂直 及水平視野所涵蓋的地面影像涵蓋範圍。以飛行高度100 公尺為例,本實驗中所 使用的相機垂直夾角與水平夾角分別為70.0 度與 86.0 度,由式 (2) 可得在 100 公尺的距離下,攝影時目標平面的垂直涵蓋範圍約為140 公尺,水平涵蓋範圍約 為186.5 公尺。 w = 2 d tan ( α 2 ) 本研究此次實驗中欲以150 公尺做為旋翼機飛行的基準高度,向上與上向下 調整50 公尺來比較不同高度下的物件偵測與物件定位結果。表 4 為在 100、150、 200 公尺時實驗用攝影機正對地面攝影時的垂直與水平視野範圍的距離,不考慮 攝影機有傾斜的狀況下,可得知在這幾個高度中地面景象視野範圍最為狹窄的便 是在100 公尺處的視野範圍垂直距離,為 140 公尺,因此在設定旋翼機飛行路徑 時最優先考慮此項目。 表 4. 不同高度實驗用攝影機對地面的地景攝影視野範圍 高度 (公尺) 垂直距離 (公尺) 水平距離 (公尺) 100 140 186.6 150 210 279.9 200 280 373.2 本研究根據上述數據,利用Google Earth 抓取實驗場域中實際 140 公尺的距 離在衛星圖像上的相對比例線段,並且與設定好路線的模擬圖比較,利用調整透 明度方式,即可如圖 20 所示疊圖,圖 20 中的虛線是在圖上重新描繪在該影像 上140 公尺該有的比例長度,用以確認飛行路徑中攝影的對地視野範圍是否涵蓋 (2)

目標。以圖 20 而言,飛行時欲拍攝之目標物為一棟建築,根據虛線在圖中的長 度,可以推估在飛行未發生偏傾斜的情況下,可搜集完該區域的影像,再加上飛 行速度設定於5 m / s、攝影機幀率可達 30 FPS ,可推估出攝影影像的重疊率超 過50 %。 圖 20. 疊圖確認飛行路徑視野能否涵蓋目標物 考慮飛行時相機可能隨無人機發生傾斜,對地拍攝的影像會與預期的區域產 生誤差,圖 21 假定相同高度 100 公尺下相機在垂直視野方向傾斜了 5 度,在圖 中原本會被涵蓋在攝影範圍的車輛,因為相機傾斜而脫離相機視野範圍,以圖 21 而言,相機傾斜 5 度地面視野範圍位置將產生了 12.3 公尺的偏移量。假定兩影 像重疊率50%的情形,考慮相機恰好傾斜兩反方向,並設定至多可容許重疊率下 降至30%,以防些微姿態測量誤差造成重疊率誤判。

圖 21. 相機傾斜時拍攝的範圍 參照圖 22,以本研究中長度為 140 公尺的垂直視野為例,若有一目標物位 在兩相鄰區域影像的重疊區內,若攝影過程攝影機傾斜使的重疊區消失,極可能 使重疊區的目標物件不在影像之中。在考量重疊率最低為30 % 、兩影像相機傾 斜角度相同之相反方向,一個影像的垂直視野距離最多可容許的偏移量為 14 公 尺,即約可容許8 度以內的相機傾斜。因此本研究除了路徑設定考慮 50 % 重疊 率外,也擇定平均風速小於三級的時間搜集影像,降低風對旋翼機傾斜造成的影 響,方便搜集空拍影像。 圖 22. 重疊率 50 % 、30 % 以及影像未重疊之情形 本研究以 150 m 之空拍影像進行訓練,並將空拍影像按照區域分成 5 區的 影像,且選定建物與車輛為欲辨識之物件。空拍資料使用旋翼機搭載本實驗中使 用之攝影機,分別在100m 、150m 、200m 的高度對地蒐集高雄大學內管理學 100 m 重疊區 70 m 42 m 重疊區 重疊率50% 重疊率30% 未重疊 140 m

院、法學院、圖資大樓、行政大樓、人文社會學院以及宿舍區的空拍影像及飛行 姿態資料,路徑為繞該棟大型建築物飛行,使得蒐集之影像可涵蓋建築物及周遭。 蒐集完影像後本研究將使用高度150 m 所蒐集的影像訓練偵測模型,目的是 讓此模型能辨識出校園內的建物與車輛。在標記完類別及位置的影像中,將隨機 抽出標記影像中的4 / 5 當作訓練集 (Training set) ,剩下 1 / 5 的影像則做為測試 集 (Testing set) 訓練物件偵測模型。本實驗中總共標記 2208 次車輛與 1176 次建 築物,模型會以 YOLOv4 所提供的 yolov4.cfg 檔案調整,根據所需偵測的物件 類別數量依官方文件指示修改 classes 、 filters 等參數,預訓練的權重檔案則是 使用 yolov4.conv.137 ,調整參數並以空中 150 公尺處的空拍影像訓練完成辨識 模型後,本研究將以此模型偵測分別位於離地100 公尺、150 公尺及 200 公尺高 度的空拍影像,探討特定高度的空拍圖是否適用於不同高度的影像,此時可適度 調整 yolov4.cfg 檔案裡 weight 、 height 參數,提高輸入影像的解析度,可提高 辨識準確性,但相對會增加辨識所需的時間。而此結果能對於決定訓練模型時在 空拍影像高度訂定的策略,以期可花費較少的時間訓練可適用於不同高度的適用 模型。本研究將探究對同一物體辨識相異高度空拍影像時目標物的信心程度 (Confidence Score) ,信心程度是指一個邊界框中涵蓋一個物件,且這個物件是 特定類別的機率,若是信心程度越高,即時該邊界框內含一個物件,並且這個物 件是特定類別的機率越高。因此了解辨識模型在不同高度下辨識物件的信心程度, 就能了解是不是只蒐集一個高度的空拍影像,就足以套用在其他高度的空拍影像 上應用。 空拍影像經物件偵測流程可辨識出影像當中物件的類別及其座標,本研究將 據物件在影像中的位置利用三角函數計算分量,並用極座標推算出目標物在實際 空間的經緯度。在本章節中預期了解計算後全球衛星導航系統座標位置結果的精 確性,查驗不同高度下同一部車輛在不同的觀測位置及飛行資態下,以本研究所 提的方法預測所產生的多個預測的座標是否具有一致性,預測的座標與實際位置

差異。本研究在空拍影像中擇定3 輛相異車輛,利用我國內政部國土測繪圖資雲 服務取得特定車輛所在位置的實際全球衛星導航系統座標作為本研究定位出之 座標的對照。在選擇空拍影像時,本研究將參考影像拍攝時間的飛行姿態資料, 考慮到前述影像重疊率問題,本研究捨棄俯仰角或翻滾角過大的資料,並取影像 前後連續飛行姿態資料,對俯仰角以及翻滾角剔除與上一幀變動過大或遇到陣風 情形下所攝圖片,避免影像與量測值間因時間校正的微小誤差導致飛行資態與拍 攝照片的角度不匹配,本研究預期在角度變動量較低的情況下進行實際目標物座 標推估,降低預期外的飛行姿態與拍攝影像間對時誤差造成的影響。 本研究將驗證在不同空拍影像中的同一部車輛,利用本研究提出的方法計算 經緯度座標的結果,是否有一致性。針對同一部車輛,本研究將分成三個高度, 分別使用含有此車輛的 10 張相異空拍影像進行實驗,計算出經緯度座標取得其 據平均中心距離的的標準差,若標準差高則考慮是否剔除特定離群值,若未有特 定離群值,則代表影像中不同位置計算出來結果的一致性較低,相反的,標準差 低及代表同高度下預測位置的結果擁有一致性。 本研究對3 輛相異目標車輛的空拍影像進行取樣,利用上述方式進行實驗得 到高度100 公尺、150 公尺及 200 公尺各 10 組定位結果數據,本研究用將定位 結果以 K-Medoids 選出各車輛在不同高度下的各自代表點,觀察代表的點偏離 車輛實際全球衛星導航系統座標的情形。 K-Medoids 類似於中位數的概念,從 K 個點當中找出一代表點,此點與其他 K-1 個點間差距的總和會是所有點當中 最小的。以 XY 平面上三相異點 a ( 2, 4) 、 b ( 5, 6) 、 c ( 7, 2) 為例說明如何 用K-medoids 取一個群當中的代表點,如圖 23 所示,此時 K 等於 3。

(a) 點 a 與其他點連線距離 (b) 點 b 與其他點連線距離 (c) 點 c 與其他點連線距離 圖 23. K-medoids 說明示意 在圖 23 (a) 中,可看到 a 點與 b 、 c 兩點的距離分別為 3.61 與 5.39,與 相異2 點總和為 9,圖 23 (b) 中, b 點與其他相異 2 點相距之總和為 8.08,圖 0 1 2 3 4 5 6 7 0 1 2 3 4 5 6 7 8 Y -axi s X-axis 點 a 與其他點連線距離 a 3.61 5.39 0 1 2 3 4 5 6 7 0 1 2 3 4 5 6 7 8 Y -axi s X-axis 點 b 與其他點連線距離 b 3.61 4.47 0 1 2 3 4 5 6 7 0 1 2 3 4 5 6 7 8 Y -axi s X-axis 點 c 與其他點連線距離 c 5.39 4.47

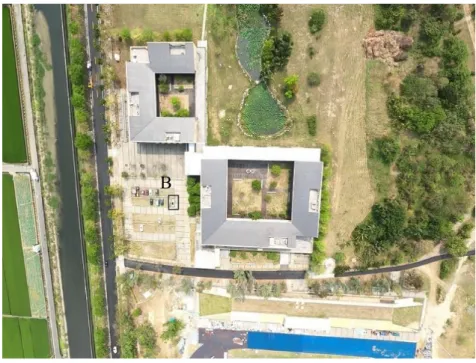

相異的點之距離總和8.08 為最小,因此點 b 會被選為代表點。 在本研究當中 K 為 10,代表在同一高度的 10 筆定位座標中取一代表點, 以此了解本研究中提得出的方法是能有效預測目標位置。另外藉由三個不同高度 標準差與偏離目標實際位置的情況,也能了解在不同的高度對定位結果的影響。 第二節 實驗結果與評估 本次實驗擇定3 相異車輛,分別以車輛 A、B、C 代稱,圖 24、圖 25、圖 26 所標示的車輛,即實驗中作為定位的目標物。實驗中此 3 輛相異車輛在 3 個 不同高度下的影像將各取 10 張,評估本研究所提出的架構中物件偵測流程與物 件定位流程的結果。 圖 24. 空拍圖中的車輛 A A

圖 25. 空拍圖中的車輛 B 圖 26. 空拍圖中的車輛 C 本研究在物件偵測流程所採用的工具為 YOLOv4 及其演算法,做為訓練模 型及辨識使用,每當偵測一幀影像,本研究所使用的物件辨識工具會輸出目標物 件在影像中 YOLO 格式的座標位置資訊、分類結果以及所辨識出的物件信心程 B C

度,該分數越高時表示 YOLO 認為邊界框中的物件屬於該類別的機率越高。 即時影像辨識為降低辨識所需時間需犧牲些微準確性,但因即時影像攝影為 連續的影格,會有大量的圖片產生,因此本研究認為即使目標物被辨識出來的次 數只有圖片總數的一半,仍可透過大量的連續影像取得足夠的樣本,得出目標物 在影像中的位置用以測算目標物的全球衛星導航系統座標,若在其他高度下,目 標物平均有足夠的信心程度以及辨識率,便可確定只需蒐集一個高度的空拍影像 就能應用在不同高度飛行上的即時影像辨識,節省蒐集資料的時間。 表 5、表 6 與表 7 分別是三部車輛在不同高度下的信心程度,每個高度分 別有10 筆資料,代表目標車輛 10 張相異圖片中在偵測後,在圖片上被判斷為車 輛的信心程度。車輛 B 在三個不同高度下的信心程度差異較低,而車輛 A 與 C 在 200 公尺的高度下出現較低的信心程度,車輛 C 雖在 200 公尺的高度下, 未在全部的影像中皆被辨識出,但仍有80 % 的情形下可以被辨識出是車輛。

表 5. 車輛 A 在影像辨識中被辨識出時擁有的信心程度 攝影高度:100 公尺 信心程度 攝影高度:150 公尺 信心程度 攝影高度:200 公尺 信心程度 1 90 % 97 % 96 % 2 70 % 97 % 99 % 3 99 % 100 % 77 % 4 100 % 79 % 78 % 5 99 % 100 % 92 % 6 88 % 97 % 86 % 7 97 % 98 % 45 % 8 100 % 99 % 59 % 9 99 % 96 % 99 % 10 76 % 99 % 76 % 平均 91.8 % 96.2 % 80.7 % 表 6. 車輛 B 在影像辨識中被辨識出時擁有的信心程度 攝影高度:100 公尺 信心程度 攝影高度:150 公尺 信心程度 攝影高度:200 公尺 信心程度 1 99 % 98 % 85 % 2 97 % 96 % 93 % 3 75 % 94 % 83 % 4 95 % 93 % 94 % 5 98 % 61 % 99 % 6 97 % 93 % 98 % 7 93 % 86 % 99 % 8 98 % 94 % 97 % 9 67 % 96 % 98 % 10 97 % 92 % 98 % 平均 91.6 % 90.3 % 94.4 %

表 7. 車輛 C 在影像辨識中被辨識出時擁有的信心程度 攝影高度:100 公尺 信心程度 攝影高度:150 公尺 信心程度 攝影高度:200 公尺 信心程度 1 99 % 100 % 84 % 2 99 % 98 % 100 % 3 78 % 64 % 90 % 4 63 % 89 % 33 % 5 64 % 98 % 未辨識出 6 99 % 43 % 34 % 7 99 % 未辨識出 75 % 8 99 % 100 % 100 % 9 99 % 99 % 未辨識出 10 未辨識出 98 % 94 % 平均 88.8 % 87.7 % 76.3 % 就目標車輛的辨識情形而言,可以認定單使用在高度150 公尺處所蒐集的影 像作為訓練資料集,其訓練後的模型是可以用在不同高度上的,並且本研究認為 在較高處進行訓練資料的蒐集,訓練後的模型搭載在無人飛行載具上飛行高度低 於或等同蒐集空拍影像時的飛行高度時,信心程度與辨識準確性所受到的影響較 小。 本研究在物件定位流程中使用三角函數與極座標,從拍攝的影像計算目標實 際位置。每一次計算使用的資料包括同一時間點所攝影像與飛行姿態資料。空拍 影像如圖 24、圖 25、圖 26,影像上面分別有車輛 A 、 B 與 C ,經影像偵 測後可得此三台車輛在影像上面的座標,經再次轉換後取得以影像中心為原點, 機頭方向 ( 即影像正上方 ) 為 X 軸的新座標方便計算。飛行姿態資料中會有 無人飛行載具在此時間點的全球衛星導航系統座標、高度,以及其俯仰角、翻滾 角和偏航角。 A 、 B 與 C 三相異車輛在 100 公尺、150 公尺、150 公尺的高度下,以先 前所取樣的各 10 筆影像與飛行姿態資料,經三角函數與極座標、直角座標間的

轉換計算出車輛的全球衛星導航系統座標,所得結果如表 8、表 9、表 10 所陳 述,表中的橫軸代表東經,縱軸則代表北緯。 表 8. 車輛 A 定位位置與實際目標 表 8 為車輛 A 在 100 公尺、150 公尺、200 公尺三種不同的飛行高度所蒐 集的各十筆影像及飛行姿態所計算出的位置,在不同高度位置所計算出的結果散 佈各有集中的趨勢,整體而言以100 公尺高度的飛行資料計算出的結果與實際目 標所在位置的落差較少。 22.73289 22.7329 22.73291 22.73292 22.73293 22.73294 22.73295 22.73296 22.73297 22.73298 22.73299 120.28867 120.28872 120.28877 120.28882 120.28887 車輛 A 定位結果 100公尺 150公尺 200公尺 實際目標位置 5 m 1 m

表 9. 車輛 B 定位位置與實際目標 表 9 為車輛 B 於不同高度下計算位置的結果分布情形,100 公尺、150 公 尺、200 公尺計算出的座標有一致性,其中以 100 公尺高度的資料所得的結果最 靠近實際目標位置。 表 10. 車輛 C 定位位置與實際目標 22.7359 22.73591 22.73592 22.73593 22.73594 22.73595 22.73596 22.73597 22.73598 22.73599 22.736 120.28127 120.28132 120.28137 120.28142 120.28147 車輛 B 定位結果 100公尺 150公尺 200公尺 實際目標位置 5 m 1 m 22.7351 22.73511 22.73512 22.73513 22.73514 22.73515 22.73516 22.73517 22.73518 22.73519 22.7352 120.28593 120.28598 120.28603 120.28608 120.28613 車輛 C 定位結果 100公尺 150公尺 200公尺 實際目標位置 5 m 1 m

表 10 為車輛 C 在三相異高度下所計算出的結果的分布情況,當中以 100 公尺組別的結果有較高一致性並且整體更靠近目標實際位置,150 公尺的組別則 一致性稍低,整體上計算結果離目標物較遠。 為更加了解不同高度對測量與計算所得的全球衛星導航系統座標的影響, 本研究將其以高度進行分組,並整理出表 11、表 12、表 13,探討不同高度下 定位出的全球衛星導航系統座標一致性程度、準確性。本研究使用標準差衡量同 組結果資料的一致性程度,標準差越大即表示同組資料的一致性低,相反則表示 有較高的一致性。準確性則是指所得結果與實際位置上的差距,本研究中又採用 K-Medoids 得到一車輛在一高度下所得多個定位結果的代表點,並取此點與目標 實際全球衛星導航系統座標的距離,若距離越小,則代表準確度越高。本研究認 為無人飛行載具有相同的角度偏誤時,會因測量高度的不同導致定位的偏移量有 所差別,以三角函數所計算地面相對位置向量的偏移量會隨飛行高度增加而加大。 表 11. 飛行高度 100 公尺車輛位置標準差與誤差 車輛 A 車輛 B 車輛 C 標準差 0.77 m 0.82 m 0.67 m 代表點緯度 22.73295 22.73593 22.73515 代表點經度 120.28881 120.28137 120.28602 代表點與目標距離 4.09 m 3.79 m 5.20 m 表 12. 飛行高度 150 公尺車輛位置標準差與誤差 車輛 A 車輛 B 車輛 C 標準差 0.80 m 1.40 m 1.70 m 代表點緯度 22.73292 22.73593 22.73514 代表點經度 120.28877 120.28136 120.28602 代表點與目標距離 9.51 m 5.06 m 6.24 m

表 13. 飛行高度 200 公尺車輛位置標準差與誤差 車輛 A 車輛 B 車輛 C 標準差 1.51 m 1.31 m 1.19 m 代表點緯度 22.73294 22.73595 22.73515 代表點經度 120.28874 120.28134 120.28600 代表點與目標距離 11.78 m 6.49 m 6.74 m 如圖8 所示,當飛行高度 100 公尺時,三相異車輛計算出的全球衛星導航系 統座標位置標準差皆在 1 公尺以內,分別為 0.77、0.82 與 0.67 公尺,即以平均 的概念由組內結果所得的座標,與同一組內所有座標相距平均小於 1 公尺。150 公尺和200 公尺高度的所定位的結果,三輛車標準差均在 2 公尺以下,標準差最 大的組為車輛C 在 150 公尺定位的結果,標準差為 1.7 公尺。為了評估定位的精 準度上,本研究在相異車輛的每組資料中以K-Medoid 找出一代表點,並計算此 點與實際全球衛星導航系統座標的距離,由表 11、表 12、表 13 當中可以看到, 車輛 A 在 100、150、200 公尺計算得出的座標代表的點與目標的差距分別為 4.09、 9.51 及 11.78 公尺,隨高度增加誤差增多,精準度也減少,再觀車輛 B 與車輛 C 以 100、150、200 公尺資料所計算的位置,同樣是隨著飛行載具高度上升,與 實際座標的差距增大。 目標車輛在相異高度的定位表現差異中,以 100 公尺組內資料所計算出的 全球衛星導航系統位置有最高的一致性與精準度。在一致性的表現上,三目標車 輛在100 公尺時,各群內的標準差皆落在 1 公尺以內,定位的座標十分相近,標 準差低於150 公尺與 200 公尺的定位結果,顯示一目標物在 100 公尺多次定位的 結果擁有比150 公尺及 200 公尺的結果有更高的一致性。在精準度方面,100 公 尺高度定位所得的座標,以 K-Medoids 取得的代表點,與實際目標位置相差約 3.5 至 5.5 公尺間,誤差約為一個車身長度的距離或更小,是三個高度中代表點

與目標實際座標差距最少的,其是150 公尺,最後是 200 公尺的定位結果,誤差 最多的為A 車在 200 公尺處的定位結果代表點,與實際位置相差約 12 公尺。 以下將以俯仰角或傾斜角測量誤差的方向來討論不同高度對定位誤差造成 的影響,在圖 16 中可由角度 θ 與無人飛行載具高度 hT 求得目標物距離地面原 點 OT 的理論實際距離 W ,關係式如式 (2) 所示。 W = hT tan(θ) 若此時俯仰角或傾斜角測量誤差為 δ 度,使得所得夾角為 θ + δ ,以此 則可推導出目標物因為角度差異得出的誤差 ΔW 如式 (3) 所示。 𝛥𝑊 = ℎ𝑇 ( tan(𝜃 + 𝛿) − tan (𝜃)) 由式 (3) 可得知誤差 ΔW 會與無人飛行載具高度 hT 成正比,因此理論上 在俯仰角、翻滾角的誤差角度相同的情況下,無人飛行載具飛行高度越高,定位 結果的誤差會越大,定位精確度會越低,而本研究所得的結果也顯示,在本實驗 中高度100 公尺處的精確度最高,其次為 150 公尺,精確度最低的則為 200 公尺 的資料定位出的結果。另外因目標物座標是使用無人飛行載具本身的全球衛星導 航系統座標為基準定位,因此無人飛行載具本身接收的全球衛星導航系統座標也 會對定位結果造成影響,但偏移的量對於不同高度的定位結果都會是一個相同的 常數,與角度誤差所造成的定位誤差所影響的部分不同。 除了觀察一目標物在100 公尺、150 公尺、200 公尺三組定位結果組內一致 性外,本研究也認為相異高度對於同一目標物的定位,需有相似的結果與一致性。 表 14 顯示一目標車輛在不同高度代表點之間距離,縱軸是兩高度相異高度,橫 軸代表車輛代號,例如縱軸「100 m – 150 m」,橫軸為 A 時,所對應的欄位即是 車輛A 在 100 公尺與 150 公尺兩相異高度定位代表點間的距離為 5.53 公尺,如 (2) (3)

下表14 所示。不同組定位得到的代表點之間距離越小,表示組與組之間定位的 結果較為相近,有較高的一致性。 表 14. 車輛各高度代表點間距離 A B C 100 m - 150 m 5.53 m 1.30 m 1.09 m 150 m - 200 m 3.93 m 2.64 m 1.35 m 100 m - 200 m 7.74 m 3.13 m 1.72 m 車輛 A 在不同高度的代表點,兩兩之間距離相差約 4 到 8 公尺,在 100 公 尺下與200 公尺的定位相差最多,相差了 7.74 公尺,其中以在 100 公尺得出的 代表點離其餘兩高度之代表點較遠,從表 8 中也可看出。車輛 B 相異高度代表 點兩兩之間距離約在 1 到 3 公尺,同樣 100 公尺高度與 200 公尺高度的代表點 距離最大,為3.13 公尺。車輛 C 相異高度兩兩代表點之間的距離則都落在 1 到 2 公尺之間,三輛車當中的車輛 B 與車輛 C 在相異高度的代表點間差距較小, 也代表著不同高度的群間定位的結果較為一致,由表 9 與表 10 中可看見在相異 高度定位的點,不同高度群的分佈狀況,群與群間位置重疊的情形較表 8 中的 車輛 A 更多。從實驗結果來看,在不同高度以本研究使用的方法定位,能夠得 到的座標位置是相近的。在本實驗中所攝影像在不同高度下,由表 4 中可得知, 影像中對角線對應所涵蓋地面的距離從233 公尺到 466 公尺不等,又在飛行高度 不同的情況下定位結果之代表點間相差未達 10 公尺,此誤差佔影像涵蓋範圍之 對角線距離的比例未到5 %,因此本研究認定所提出的方法在不同高度下的定位 具有穩定的結果。 在本研究中所提出的系統裡,物件偵測流程中辨識出影像裡的物件,並取得 目標物件在影像中的位置,影像的資訊進一步在物件定位流程中分析,根據同一

時間的飛行姿態資料、無人飛行載具高度定位目標物的全球衛星導航系統座標。 本研究中物件偵測流程使用 YOLOv4,並以 150 公尺所拍攝的影像訓練的模型 辨識在本實驗中挑選的目標物,實驗結果整體辨識率為96 % ,並且在三組高度 的平均信心程度皆高過七成,代表在同一場域中,僅需蒐集一個高度的空拍圖, 就能搭載在無人飛行載具上即時偵測其他高度的空拍影像,辨識出目標物件及取 得物件在空拍圖中的座標。接著使用空拍圖座標資訊與同一時間的無人飛行載具 飛行姿態、高度,透過三角函數與極座標的方式定位的全球衛星導航系統座標在 相異高度的組內多筆資料標準差約在一公尺左右,具有一致性,同一目標物的不 同組間的代表點分別都相距 1 到 8 公尺之間,代表預測結果在組外仍保有一致 性,不同高度下的定位結果是相近的。經實驗驗證及結果評估後,本研究認為物 件偵測流程與定位流程所提的方法皆可實際使用,實現本研究所提的即時空拍影 像辨識與定位之系統。

![圖 1. 深度學習與表徵學習、機器學習、人工智慧的關係[13]](https://thumb-ap.123doks.com/thumbv2/9libinfo/7426639.106556/14.892.265.626.116.283/圖1深度學習與表徵學習機器學習人工智慧的關係13.webp)

![圖 6. 雙眼視野交疊產生立體視覺 在地面上,自動駕駛車輛與自主式機器人使用立體視覺估算障礙物或目標物 距離,並有高度即時性。在無人飛行載具因為載重有限,必須減輕重量,難以搭 載雙鏡頭或攝影機,與自動駕駛車輛和自主式機器人的近距離攝影[26]不同,無 人飛行載具在高空對地面進行攝影,距離物件至少數十公尺,因此需要不同的方 法計算目標物距離。共線條件方程式 (Collinearity equation) 常被應用在遙測 (Remoting Sensing) 與航空攝影測量中[27],利用光線直](https://thumb-ap.123doks.com/thumbv2/9libinfo/7426639.106556/18.892.345.546.122.282/同無人飛行載具在高空對地面進行攝影距離物件至十公尺與航空線直.webp)