曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 91 教育科學研究期刊 第五十八卷第一期 2013 年,58(1),91-116 doi:10.3966/2073753X2013035801004

以學生評鑑教師教學量表決定教師的開課或

去留可行嗎?混合 IRT 分析取向

曾明基

*邱皓政

國立東華大學 課程設計與潛能開發學系 國立臺灣師範大學 管理學院張德勝

羅寶鳳

國立東華大學 課程設計與潛能開發學系 課程設計與潛能開發學系 國立東華大學摘要

本研究主要探討以學生評鑑教師教學量表決定大學教師開課或去留的可行性。研究對象 為東部某大學大學部學生,總樣本數為 6,111 人。 有別於過往學生評鑑教師教學的實證研究皆建構在古典測驗理論,本研究為了更嚴謹地 回應學生評鑑教師教學的評鑑結果,因此使用近代測驗理論進行分析,並進一步考量學生的 潛在異質差異對學生評鑑教師教學的影響。研究結果顯示,在未考慮評鑑教師的學生潛在異 質差異時,教師可輕易通過學校所訂定在學生評鑑教師教學量表的效標門檻。但進一步考慮 學生潛在異質性發現,不同潛在類別的學生評鑑教師教學的方式差異頗大。針對上述結果, 本研究對大學教師及學生評鑑教師教學提出相關的建議。 關鍵字:學生評鑑教師教學、混合 IRT 分析 通訊作者:曾明基,E-mail: d9988101@ems.ndhu.edu.tw 收稿日期:2012/04/18;修正日期:2012/12/13;接受日期:2013/02/23。92 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳

壹、緒論

過往學生評鑑教師教學的目的主要在協助教師改進教學(張德勝,2002),畢竟學生是 最能提供教室事件第一手資料的人,他們的意見反應對協助教師改進教學應有所助益。而且 學生評鑑教師教學結果可以說是教師教學績效的指標之一,透過學生具體分數的呈現,清楚 說明教師被評鑑的結果,無論評鑑的結果是顯現教師教學的優點或缺點,都可以提供教師有 關學生對自己教學看法的感受。 透過此種學生評鑑教師的回饋資料,教師可以瞭解教學目標是否達成、教材內容是否充 分、教學方法是否適當、師生關系是否良好、作業規定是否過量等,以作為改進教學之參考。 教師就在學生評鑑教師教學結果所提供的訊息下,不斷修正與改進自己的教學,進而提升教 學品質。 近年來高等教育的發展趨勢逐漸將重心放在學生的學習上(Donald, 2006; Kreber, 2006; Rice, 2006; Webler, 2006),使得學生評鑑教師教學也開始產生了質的改變,雖然學生評鑑教 師仍舊是以改進教師教學為主,但是卻以學生學習為中心來評鑑教師(Vincent & Kennon, 2003, 2008)。基於此,各校大多訂定了大學教師在學生評鑑教師教學量表上需通過的基本評 鑑分數,例如北部某大學規定在五等量表的學生評鑑教師教學量表上,任課教師的評鑑分數 若低於 3.5 分,則教師會受到校方與系所主管的關心並要求檢討改善。而東部某大學也以 3.5 分作為學生評鑑教師教學的通過門檻,專任教師的學生評鑑教師教學分數若低於 3.5 分,就需 要接受教學輔導,若學生評鑑教師教學分數再不通過,則日後也不能開設同一門課,並作為 後續是否續聘的重要參考依據。 雖然學生評鑑教師教學的立意良善,可以提升高等教育的教學品質、反映教師教學績效、 提升學生學習動機、作為教師升等參考。但從最初實施單純的教學意見調查,直至後來成為 各種評鑑教師升等獎勵措施之依據,其調查結果已變成教師升等、續聘、長期聘任、停聘、 不續聘及獎勵之重要甚至是唯一之參考(周祝瑛,2009)。 在這樣的評鑑氛圍下,大學教師除了透過學生評鑑教師教學持續精進自己的教學品質 外,學校當局是否也該審視以學生評鑑教師教學量表決定教師的開課或去留是否可行?本研 究即以此為出發,期望透過實證研究回應此一現象,以供大學教師及政策制定者參考。本研 究在分析方式上有別於過往建構在古典測驗理論的實證研究,為了更嚴謹地回應學生評鑑教 師教學的評鑑結果,因此使用近代測驗理論進行分析,並進一步考量學生的潛在異質差異對 學生評鑑教師教學的影響。曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 93

貳、文獻探討

本研究主要探究以學生評鑑教師教學量表決定教師開課或去留的可行性。首先說明學生 評鑑教師教學評鑑取向的轉變,以及過往學生評鑑教師教學的實證分析取向,使讀者對學生 評鑑教師教學議題發展有一清楚輪廓。進一步說明學生評鑑教師教學的評鑑方式建構在古典 測驗理論的缺失,進而指出學生評鑑教師的評鑑方式建構在近代測驗理論的必要性,以及考 量學生潛在異質差異對學生評鑑教師教學的影響。本研究將以更嚴謹的實證分析,清楚說明 學生評鑑教師教學量表是否可以決定教師的開課或去留。一、學生評鑑教師教學的轉變:以「改進教學」為中心轉向以「評鑑教學」

為中心

國內、外在探討影響學生評鑑教師教學的議題上累積了大量的實證研究(曾明基、邱于 真、張德勝、羅寶鳳,2011;Beran & Violato, 2005; Chang & Ross, 2006; Cohen, E. H., 2005; Marsh, 2007; Spooren & Mortelmans, 2006),以作為大學教師改進教學的參考,教師可透過對 影響學生評鑑教師教學因素的瞭解,不斷修正與改進自己的教學,進而提升教學的品質。 然而,當各校陸續在學生評鑑教師分數訂定明確的基本通過門檻(效標參照)後,學生 評鑑教師教學有了實質的改變,學生評鑑教師教學的分數可以決定教師的開課和去留,而不 再僅是以改進教師教學為目標,學生評鑑教師教學的評鑑取向漸進地從改進教師教學為中心 轉變成評鑑教師教學為中心,學生評鑑教師教學的評鑑結果可以實質地影響到大學教師的開 課及續留(張德勝、邱于真、羅寶鳳,2011)。 目前國內大學校院對於學生評鑑教師教學大多設有基本評鑑的門檻分數,例如:北部某 大學、東部某大學等,規定在五等量表的教學評鑑工具上,任課教師的學生評鑑教師教學分 數若低於 3.5 分(五等量尺分數),則日後就不能開設同一門課。有些學校甚至訂出教師如果 低於此門檻分數,則列為觀察名單、停聘或不得續聘。學生評鑑教師教學的結果實質影響到 教師的任教及工作,在評鑑制度丕變的情況下,過往影響學生評鑑教師教學的因素是否仍可 以決定教師的開課與去留,有待後續加以釐清。二、過往探究學生評鑑教師教學的兩大實證取向

過往在探究有何因素影響學生評鑑教師教學時,主要以解釋型模型和準實驗設計為主, 茲分述如下:(一)解釋型模型取向

在解釋型模型取向上,學生評鑑教師教學模型又可細分成微觀的學生角度(Beran & Violato, 2005; Cohen, E. H., 2005; Spooren & Mortelmans, 2006)與巨觀的班級、教師角度(張94 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳 德勝等,2011;Bowling, 2008)來探討。這些模型所納入變項除了學生層次的背景變項外,也 同時納入了教師層次及學校層次的變項,在常模參照的角度下,旨在說明什麼因素可以影響 學生評鑑教師教學,有何因素的影響力較大,藉以提供大學教師作為改善教學的參考。 但是所納入變項大都以學生、教師及學校的外在變項為主(如:學生性別、教師性別、 學科領域、班級人數),這些背景變項即便對學生評鑑教師教學有所影響,大學教師也無法 透過實質的改變來改善學生評鑑教師教學。

(二)準實驗設計取向

在準實驗設計取向上,不著重於解釋型模型所探討的學生、教師及學校的各種外在變項, 而是透過準實驗設計以隨機分派的方式,來探討所操弄變項不同的外顯組別學生,在學生評 鑑教師教學分數上的差異。 在所操弄的變項上,學生評鑑教師教學的外在分類組別不論是使用網路問卷或是使用紙 筆問卷作答(Chang, 2005)、或者是改變學生評鑑教師教學題目在評鑑量表上的出現先後順序 (曾明基、張德勝、羅寶鳳、邱于真,2012),皆不會影響到學生在學生評鑑教師教學量表上 的填答分數。 雖然準實驗設計取向透過較嚴謹的控制程序,來探討操弄變項對學生評鑑教師教學的影 響,但仍同解釋型模型般,皆建構在古典測驗理論上,使得所估計參數依舊面臨樣本依賴 (sample dependence)與題目依賴(item dependence)的窘境,所估計參數的穩定性變動大。 此外,兩種取向的實證研究目前僅少數提供適配度檢定,並無法清楚得知研究者所發展的解 釋型模型或是所操弄的變項在實證樣本上的適配情形,因此推論的有效性值得商榷。三、同時考慮參數不變性及樣本異質性的新分析取向

由於過往的學生評鑑教師教學議題探討,主要建構在古典測驗理論上,可能產生許多參 數估計上的缺失,也無法解決樣本依賴與題目依賴的窘境。然而,當教育行政單位以學生評 鑑教師教學的分數作為教師開課或去留的依據時,則更嚴謹的實證分析方式便有其必要性, 以更忠實反映學生評鑑教師教學的結果。基於此,本研究將說明同時考慮參數不變性及樣本 異質性的混合 IRT(mixture item response theory)模型,以作為後續探討學生評鑑教師教學的 依據。本研究在國內、外學生評鑑教師教學的議題探討上,是第一篇考慮到樣本潛在異質性的 差異對學生評鑑教師教學的影響,因此,研究方法上沒有過往學生評鑑教師的實證研究可以 支持,僅能從心理計量領域混合 IRT 模型相關的文獻來加以佐證(Asparouhov & Muthén, 2008; Muthén, B., 2006; Muthén, B. & Asparouhov, 2006; Muthén, B., Asparouhov, & Rebollo, 2006; Rost, 1990, 1997; von Davier & Yamamoto, 2004),茲說明如下。

曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 95

(一)考慮參數不變性取向

本研究對象為東部某大學,在學校政策制定大學教師需通過學生評鑑教師教學量表 3.5 分 的效標(70%的學生評鑑教師教學滿意度),以作為學生評鑑教師教學通過的基本門檻後,大 學教師在學生評鑑教師教學量表各題目上的分數可清楚地被劃分成通過與不通過兩類,以決 定大學教師之後的課程開設或是任教權。目前東部某大學的專任教師已有學生評鑑教師教學 評鑑不通過的案例,除了需接受教學輔導外,若教師所開設的同一門課程評鑑再不通過,則 日後就不能再開設同一門課,且可能面臨停聘及不續聘的情形。 在這樣的評鑑制度下,若以傳統的解釋型模型或是準實驗設計做詮釋,除了面臨古典測 驗理論的諸多缺失,使得解釋結果不精確外,學生評鑑教師教學量表的分數解釋也不再適合 以連續的外顯分數模型進行說明。為了釐清學生評鑑教師教學量表以 3.5 分為效標作為參照來 評鑑教師教學的適用性,因此改以試題反應理論(item response theory, IRT)取向進行分析, 以反映使用學生評鑑教師教學量表決定教師開課或去留的可行性。IRT 目前廣泛應用於能力的 診斷上,其強假設提供測量工具穩健的心理計量特性,包括試題與能力獨特性、較佳的測量 精確性、不同群體與試題間的連結、試題與能力置於同一量尺相互比較等,都是古典測驗理 論不足之處(Embretson & Yang, 2006; Yen & Fitzpatrick, 2006),正適合用來評鑑大學教師的 整體教學能力。IRT 的 基 本 假 定 為 單 一 向 度 性 ( unidimensionality ) 與 局 部 試 題 獨 立 性 ( local independence),即試題本身只測量單一潛在能力且試題之間的答對機率不會互相干擾。張德 勝(2002)指出,學生評鑑教師教學的內容可以分為多面向或單面向,前者可以針對教師教 學上某些特定的部分來分析,用於形成性評量較多,後者則以教師的整體教學表現來呈現, 用於總結性評量,以總結的分數來評定教師整個學期的教學績效。且 d’Apollonia 與 Abrami (1997)、Greenwald 與 Gillmore(1997)、McKeachie(1997)皆認為教學本身雖然是屬於 多層面的,但是評鑑本身應該包含一個更大、更完整的因素(global factor),而這一個大因 素底下才涵蓋了較低層次的因素。此外,本研究取向並非詳細探究影響學生評鑑教師教學的 各層面以作為教師改進依據,而是探究以學生評鑑教師教學量表決定教師開課或去留的可行 性。因此,假定學生評鑑教師教學量表符合評鑑的單向度假定(unidimensionality assumption) 應是合理的,後續將進一步檢定學生評鑑教師教學單向度的合理性。

(二)考慮樣本異質性取向

IRT較古典測驗理論精確之處在於其參數不變性,意旨用來描述一道試題的試題參數,其 估計值的獲得不受填答者能力分配的影響,而用來描述某位填答者的能力參數,其估計值的 獲得亦不受使用哪一組測驗的影響(Hambleton & Swaminathan, 1985)。換言之,當 IRT 模型 與所分析的資料間適配時,不論哪一能力的填答者來進行同一道試題的作答(藉以估計該試96 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳

題參數),均能獲得一條相同的試題特徵曲線(item characteristic curve, ICC),且同一能力填答 者無論是參與哪一道測驗試題的作答(藉以估計該等能力參數),也都能獲得一條相同的試題 特徵曲線。也就是試題和能力參數的估計值是屬於樣本獨立(sample independence),在估計 時不會因為所使用的樣本(試題或填答者)不同而獲得不同的估計結果。

由於 IRT 的樣本能力值是連續潛在變項,當樣本為有限混合分配(finite mixture distribution)時(McLachlan & Peel, 2000),則過往使用 IRT 所估計的參數不變性將可能產生 偏誤的估計參數,因此在審視學生評鑑教師教學量表的評鑑分數時,樣本的異質性 (heterogeneity)或是潛在類別(latent class)仍須一併考慮,有進行混合 IRT 分析(mixture IRT analysis)的必要性(Muthén, B., 2006; Muthén, B. & Asparouhov, 2006; Muthén, B. et al., 2006; Rost, 1990, 1997; von Davier & Yamamoto, 2004)。

當樣本異質性來自可觀察或事前透過操弄界定不同群體時,可稱這類族群為組別 (group),通常使用多群組分析模式來探討可觀察組別間的異質性(如前述的解釋型模型取 向、準實驗設計取向,以及 IRT 取向下的 DIF 分析),而當異質性來自不可觀察的族群時,則 稱這些族群為類別(class),探討類別間異質性的方法通常稱為潛在類別分析(latent class analysis, LCA)。潛在類別模型(latent class model, LCM)的基本假定是試題的條件獨立性 (conditional independence of items),這樣的假定和 IRT 的條件獨立性相同(local independence assumption)。然而,這兩個模型最大的不同點在於,LCM 在估計潛在能力時假定潛在能力是 類別的,而 IRT 假定潛在能力是連續的。

Rost(1990, 1997)提出結合 Rasch 模型和 LCA 的混合 Rasch 模型(mixture Rasch model, MRM),以解決這兩種分析取向之缺點,並保留各自擁有的優點。MRM 允許 LCM 在不同的 潛在分類組裡有潛在變項的變異。在 MRM 架構下,同一潛在分類組裡的樣本有相同的傾向回 答每一個試題,也就是在同一潛在分類組裡的 IRT 模型對於同一潛在分類組裡的樣本是相同 的,樣本在同一潛在分類組裡可在不同的能力之間變動。然而,在 LCM 架構下,在同一潛在 分類組裡的樣本在他們的潛在能力和試題反應是同質的,沒有變異存在。 此外,LCM 和 IRT 另一個不同的差異在於,在 IRT 架構下潛在變項和反應機率之間有一 個明確的函數關係,然而在 LCM 架構下卻沒有明確的函數關係(Masters, 1985)。當測驗長度 增加時,反應組型矩陣將變得離散,在 LCM 架構下過於離散的情形可能產生問題,因為 LCM 的參數並沒有被有效的估計。而在 MRM 架構裡的 IRT 模型可潛在地處理這樣的離散問題, 因為 IRT 可加入一個參數模型(例如:累積的邏輯斯或常態肩型函數)在 LCM 裡,伴隨這樣 的強假設來描述潛在變項和反應機率之間的關係。且同時結合 IRT 與 LCM 的混合 IRT 研究也 指出(Muthén, B., 2006; Muthén, B. & Asparouhov, 2006; Muthén, B. et al., 2006),混合 IRT 相較 於傳統 IRT 和 LCM 取向的分析更適配資料,且可能獲致與傳統的 IRT 和 LCM 不同的結果並 提供更細緻的分析與檢定。

曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 97 基於此,本研究主要想釐清以學生評鑑教師教學量表決定教師的開課或去留是否可行? 將以學校在學生評鑑教師教學量表上所訂定的 3.5 分閥限值作為效標參照,採用混合 IRT 進行 分析,透過細緻且嚴謹的檢定來回應此一政策的適用性及合理性。然而,本研究所納入的東 部某大學學生評鑑教師教學量表的評定方式,是在學期末由各別學生評鑑教師整學期的整體 教學表現,依網路填答採用李克特式五點量尺評定,而非由學生在各題項上直接評鑑教師的 分數通過與否。每題的效標參照為 3.5 分乃由學校訂定。為了詳細回答東部某大學以 3.5 分作 為效標參照來決定教師開課或去留的合理性,因此在分析上將學生填答的分數超過 3.5 分者 (實際填答 4 分、5 分的學生)表示為通過,3.5 分以下者(實際填答 1 分、2 分、3 分的學生) 表示為未通過,以進行後續的探討。分析方式雖可完整回答東部某大學的學生評鑑教師教學 以 3.5 分作為效標參照的現況,但將原始五點量表轉換為兩點量表,將大幅損失訊息。 若僅是想單純探討有何因素影響學生評鑑教師教學,而非探討以學生評鑑教師教學決定 教師開課或去留的合理性,則可以採用混合多元計分的 IRT 方式直接分析學生評鑑教師量表 的原始量尺,將更能完整捕捉影響學生評鑑教師教學的因素。 因此,本研究在後續的分析說明上,將同時呈現兩種不同實證取向的分析方式,包含作 為決定教師開課或去留的效標參照 MRM,以及學生原始填答五點量尺的混合多元計分 IRT 模 型。MRM 以東部某大學訂定的 3.5 分作為效標參照,將五點量尺重新轉換成評鑑通過與不通 過的二點量尺,雖然會損失許多訊息,但可真實回答東部某大學以學生評鑑教師教學決定教 師開課或去留的合理性,而混合多元計分 IRT 模型主要作為探討有何因素影響學生評鑑教師 教學,此一部分可修正傳統解釋型模型分析不足之處。

在 MRM 主要以 Rost(1990, 1997)的模型作為說明,而混合多元計分 IRT 模型主要以 von Davier與 Yamamoto(2004)的模型作為說明。 Rost(1990, 1997)的 MRM 假定樣本母群由有限數量的間斷潛在類別群組所組成。在每 一個潛在類別群組裡有一個 Rasch 模型,但每一個不同的潛在類別群組有不同的試題難度參 數。樣本若出現在同一潛在類別群組裡,將被假定在試題上有相同的難度參數,雖然在同一 潛在類別群組裡能力值可以不同。MRM 也連結潛在類別群組參數(g),與每個樣本共同決 定樣本在該試題的相對難度以及潛在的能力參數(θjg),並影響測試試題的正確答對數量。

MRM架構下的正確反應概率如下:P(yijg=1|g, θjg)=1/1+exp[-(θjg-βig)],其中 g 是潛在類別

的指標,g=1, …, G,j=1, …, J,表示樣本,θjg是樣本在潛在類別群組裡的潛在能力,βig是

試題 i 在每一個潛在類別群組裡的 Rasch 難度參數。Rost 指出 MRM 的主要潛力在於診斷樣本 間存在潛在的質的差異,並同時就同一試題的能力以量化的方式表示。

而 von Davier 與 Yamamoto(2004)拓展了 Masters(1982, 1988)的部分計分模型(partial credit model, PCM)和 Muraki(1992)的一般化部分計分模型(generalized partial credit model, GPCM),在 PCM 架構下加入了潛在類別的概念而成為間斷的混合模型。

98 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳

參、研究方法

一、研究對象

本研究以東部某大學 97 學年度第一學期大學部班級為研究對象,本研究在徵求學生同意 之後,以一般性課程的班級為研究對象,共有 173 班,這些班級的選課人數介於 12 和 73 人 之間,扣除資料填達不全的樣本後,總樣本數為 6,111 人。二、研究工具

本研究主要使用「學生教學意見反應調查表」為研究工具,包含學生評鑑教師教學題目 15 題,內容包含教師的教學準備、教學方法、教材內容、教學評量、教學態度等。每一題題 項的滿分皆為 5 分,依學校行政規定,以 3.5 分為效標參照的通過閥限值,學生在該題目填答 分數 3.5 分以上則評鑑為通過並編碼為 1,在 3.5 分以下則評鑑為未通過並編碼為 0。表 1 為 各題項下教師通過學生評鑑教師教學的比率以及原始填答比率。由表 1 可知,整體而言,學 生在學生評鑑教師教學量表的各題項上,傾向於給任課教師 4 分及 5 分的成績,進而使得大 學教師通過學生評鑑教師教學。 表 1 學生評鑑教師教學教師通過評鑑比率以及原始填答比率(N=6,111) 題目 評鑑不通過 評鑑通過 給1分 給2分 給3分 給4分 給5分 t01 .188 .812 .005 .018 .165 .517 .295 t02 .209 .791 .006 .020 .183 .492 .298 t03 .250 .750 .007 .031 .212 .471 .279 t04 .248 .752 .007 .030 .211 .456 .296 t05 .217 .783 .006 .025 .186 .505 .278 t06 .285 .715 .007 .033 .244 .479 .236 t07 .292 .708 .009 .029 .254 .497 .211 t08 .287 .713 .013 .033 .241 .453 .261 t09 .235 .765 .006 .018 .211 .517 .248 t10 .233 .767 .005 .017 .210 .499 .269 t11 .184 .816 .007 .015 .162 .474 .342 t12 .126 .874 .004 .007 .115 .464 .411 t13 .157 .843 .003 .011 .143 .468 .375 t14 .210 .790 .006 .019 .186 .457 .333 t15 .183 .817 .005 .016 .162 .481 .335 註:各題目內容說明詳如附錄。曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 99

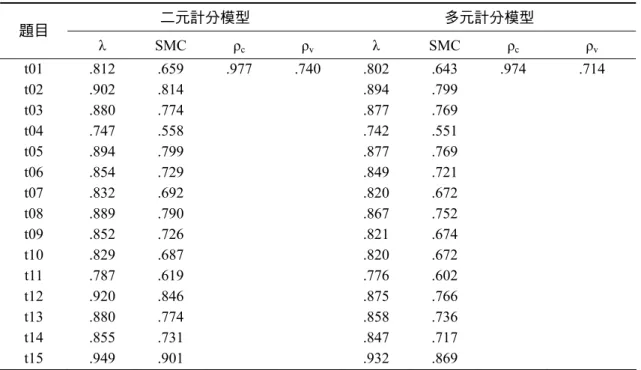

McDonald與 Mok(1995)將模型參數估計的方法分成兩大類用來分析 IRT 的單一向度, 其一為完全訊息(full information)因素分析,另一為雙變項訊息(bivariate information)因素 分析。前者所假定的局部獨立是屬於強勢型,亦即控制影響作答反應能力的條件時,每一題 的答對機率相互獨立,而後者所假定的局部獨立是屬於弱勢型,表示當排除影響作答能力的 向度後,配對試題或殘差變異間不存在共變關係。完全信息因素分析取向採用非線性的因素 分析法進行,本研究在單一向度檢驗上參考完全信息取向的概念,採用 Mplus 軟體(Muthén, L. K. & Muthén, 2006)進行非線性因素分析檢定單一向度假定是否合理。關於非線性因素分 析的觀念、說明及語法操作請參閱 Sara 與 Christine(2006)的文獻,礙於研究目的不再贅述。 適配結果在二元計分模型的 χ2=297.287, df=90, p < .001, CFI= .990, TLI= .989, RMSEA= .047, WRMR=2.456,除了卡方值較高外,其他指標顯示適配情形良好。而多元計 分模型的 χ2=7868.623, df=90, p < .001, CFI= .972, TLI= .967, RMSEA= .119, WRMR= 4.395,由於假定五點式量表為間斷的次序類別變項進行分析,因為題項的次序過多而導致 RMSEA膨脹。但整體而言,在二元計分模型及多元計分模型的整體適配度尚可接受,符合學 生評鑑教師教學量表期末總結性評鑑時單一向度的假定(張德勝,2002;d’Apollonia & Abrami, 1997; Greenwald & Gillmore, 1997; McKeachie, 1997),並具備良好的潛在信度與效度(詳如表 2)。

表 2 學生評鑑教師教學非線性因素分析單一向度檢定摘要(N=6,111) 二元計分模型 多元計分模型 題目 λ SMC ρc ρv λ SMC ρc ρv t01 .812 .659 .977 .740 .802 .643 .974 .714 t02 .902 .814 .894 .799 t03 .880 .774 .877 .769 t04 .747 .558 .742 .551 t05 .894 .799 .877 .769 t06 .854 .729 .849 .721 t07 .832 .692 .820 .672 t08 .889 .790 .867 .752 t09 .852 .726 .821 .674 t10 .829 .687 .820 .672 t11 .787 .619 .776 .602 t12 .920 .846 .875 .766 t13 .880 .774 .858 .736 t14 .855 .731 .847 .717 t15 .949 .901 .932 .869 註:λ 為各題目的因素負荷量;SMC 為個別項目信度;ρc為潛在變項的組合信度;ρv為潛在變項 的平均變異數抽取量;15 題題項的非線性因素負荷量 p 值皆小於 .001。

100 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳 L. K. Muthén(2010)指出,WRMR 是一個實驗擬合統計量,範圍從 0 到無窮大,其統計 分布尚不清楚,在其他適配指標良好的情況下,可不用作為評鑑的適配標準。為了詳細呈現 非線性因素分析結果,在此一併列出。

三、資料分析

傳統學生評鑑教師教學分析方式主要建構在古典測量理論上,參數估計面臨樣本依賴與 題項依賴的不精確。而本研究在二元計分模型及多元計分模型下皆符合期末學生評鑑教師教 學單一向度的假定,且各試題潛在的信度與效度皆良好。此外,本研究目的並非想探究各試 題的鑑別度差異,而是想透過各試題難度差異來忠實回答本研究所探究的初衷:以學生評鑑 教師教學量表決定教師的開課或去留可行嗎?並進一步考慮學生樣本異質性對評鑑結果的影 響,因此,在分析方式上使用混合 Rasch 模型及混合多元計分模型進行後續說明。肆、研究結果與討論

為了詳細探究東部某大學以學生評鑑教師教學量表決定大學教師開課或去留的合理性, 首先以 IRT 架構下的 Rasch 模型(主要反應學生真實評鑑教師)及多元計分模型(主要反應有 何因素影響學生評鑑教師)檢定學生評鑑教師教學量表在 15 題題項的項目難度和鑑別度參 數。一、傳統 Rasch 模型及多元計分模型分析

學生評鑑教師教學量表在 Rasch 模型下,Pearson χ2=27,425.307, df=32667, p > 1.000, 而概似比 χ2=8,409.777, df=32,667, p > 1.000,這兩個卡方檢驗的統計估計一致,表示 Rasch 模型與樣本的擬合程度良好(Muthén, L. K. & Muthén, 2006)。由表 3 可知,Rasch 模型各題項 的難度參數估計值介於-1.310 至-.620 logit 單位之間,鑑別度參數估計值為 1.766。而在多元計 分模型下,由於有 15 個題項,每一題項有 5 個可能的填答分數,因此有 515個細格需要估計, 因為需要估計的次數分配表實在太大,導致多元計分模型無法有效估計卡方檢驗,因此多元 計分模型僅能提供其他的整體適配度如 AIC、BIC、ABIC,以作為後續模型競爭之判準(詳 如表 4)。 由表 3 可知,就學生評鑑教師教學的角度觀之,無論在 Rasch 模型或是多元計分模型,以 大學教師的能力通過各試題 3.5 分的評鑑閥限值並不困難。在全量表 15 題題項中,大學教師 最容易通過的題項是第 12 題項「教師教學認真」,可見東部某大學的教師整體而言教學認真。 而第 7 題項「教師對於教材內容的安排難易適中」是教師最難通過評鑑的題項,教師對於教 材內容的拿捏與學生的觀點有所差異。 各題項在 Rasch 模型的難度參數,以及多元計分模型的閥限值均甚佳,表示東部某大學的曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 101

表 3

學生評鑑教師教學量表 Rasch 模型及多元計分模型分析摘要(N=6,111)

Rasch模型 多元計分模型

題目

難度(S.E.) 閥限值1(S.E.) 閥限值2(S.E.) 閥限值3(S.E.) 閥限值4(S.E.) t01 -1.002( .023) -3.033( .077) -2.211( .040) -0.978( .021) 0.546( .020) t02 -0.914( .022) -2.928( .069) -2.183( .037) -0.902( .020) 0.545( .019) t03 -0.763( .021) -2.822( .064) -1.981( .034) -0.766( .020) 0.607( .020) t04 -0.768( .021) -2.740( .071) -1.963( .037) -0.772( .020) 0.512( .020) t05 -0.884( .022) -2.932( .070) -2.093( .035) -0.874( .020) 0.614( .020) t06 -0.644( .020) -2.815( .068) -1.953( .034) -0.655( .019) 0.773( .020) t07 -0.620( .020) -2.711( .064) -1.978( .036) -0.636( .019) 0.870( .021) t08 -0.637( .020) -2.563( .052) -1.895( .032) -0.648( .019) 0.671( .020) t09 -0.818( .021) -2.923( .078) -2.221( .041) -0.816( .020) 0.719( .020) t10 -0.825( .021) -2.977( .074) -2.236( .040) -0.816( .020) 0.636( .020) t11 -1.018( .023) -2.792( .068) -2.223( .042) -0.986( .021) 0.379( .019) t12 -1.310( .027) -3.138( .077) -2.589( .049) -1.257( .022) 0.192( .018) t13 -1.143( .025) -3.253( .095) -2.457( .046) -1.109( .021) 0.291( .019) t14 -0.911( .022) -2.965( .073) -2.202( .039) -0.895( .020) 0.414( .019) t15 -1.022( .023) -3.064( .072) -2.297( .038) -1.004( .020) 0.425( .019) 鑑別度 1.766( .030) 1.772( .024) 註:Rasch 模型及多元計分模型中所有題項的難度及鑑別度參數估計 p 值皆小於 .001。 學生評鑑教師教學量表可作為有效評鑑大學教師教學的參考依據,並進一步決定大學教師的 開課和去留。然而,Rasch 模型及多元計分模型參數的不變性是建構在樣本為同質性的假定 下,若樣本群存在潛在的異質性時,則試題參數的不變性將可能產生偏誤,因此接著對樣本 的異質性進行檢定。

二、Mixture IRT 分析

學生評鑑教師教學量表在 Rasch 模型及多元計分模型假定樣本為同質性的前提下,試題的 難度與鑑別度均良好。接著進一步檢定樣本同質性的假定是否合理。Nylund、Asparouhov 與 Muthén(2007)指出,在判斷樣本異質性(潛在類別)的指標上, BIC指標和 BLRT(bootstrapped likelihood ratio test,詳細說明見 McLachlan & Peel, 2000)指 標是最適合的統計數指標,用以決定潛在類別的組數。但也指出透過比較這些統計數指標, 雖然可決定較好的分類結果,但最好的分類模型在實務上仍可能無法清楚描述母群的樣本異

102 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳

表 4

Mixture IRT模型適配度估計結果摘要(N=6,111)

混合Rasch模型 LCA1 LCA2 LCA3 LCA4

LRT -31,387.733 -31,040.288*** -30,906.723*** -30,762.578*** AIC -62,807.466 -62,144.576*** -61,909.446*** -61,653.157*** BIC -62,914.952 -62,359.547*** -62,231.902*** -62,083.099*** ABIC -62,864.108 -62,257.860*** -62,079.371*** -61,879.725*** BLRT 694.894*** 268.840*** 312.561*** Entropy 1 0.630*** *- 0.459 *- 0.480 混合多元計分模型 LCA1 LCA2 LCA3 LCA4

LRT -69,885.610 -66,314.711*** 無法收斂 AIC 139,893.220 132,873.422*** BIC 140,303.009 133,692.999*** ABIC 140,109.167 133,305.316*** BLRT -07,141.803*** Entropy 1 0.773***

註:LCA1代表傳統單一分配的 Rasch 模型以及多元計分模型。Entropy 值愈大代表潛在類別分類品

質愈精準,但影響 Entropy 因素眾多目前仍無定論,相關說明請參考 Celeux 與 Soromenho(1996)。 潛在類別的估計法為 EM 算則,在參數估計時可能面臨局部極大值收斂的情況,詳細說明見 McLachlan 與 Peel(2000)。 ***p < .001. 質性,仍須進一步考慮參數估計的有效性和合理性。因此,在後續檢定樣本異質性時,除了 以整體適配的 BIC 和 BLRT 指標為依據外,並進一步考慮內在結構參數估計的有效性和合理 性。

由表 4 可知,在混合 Rasch 模型架構下當樣本異質性為四個潛分類時(LCA4),BIC 指標

最小,且 BLRT 指標指出相較於樣本為三個潛分類(LCA3)時,適配程度獲得顯著的改善,

但 LCA4的鑑別度為-1.349( .048),表示試題無法有效鑑別學生評鑑教師,可見該模型不足

以採信。此外,進一步檢視 LCA3發現,其整體適配指標皆較 LCA2佳,且 BLRT 適配程度也

獲得顯著的改善,但是在 LCA3的第三潛在類別,所有題項試題的難度參數均不顯著,表示第

三潛在類別的 Rasch 模型也不足以採信,因此在最終模型的選擇上則以 LCA2的混合 Rasch 模

型作為後續說明依據。

此外,由表 4 下半部可知,不以學校評鑑教師教學的角度改變學生原始填答的量尺時發 現,在混合多元計分模型架構下,在 LCA3模型分析過程中 Mplus 出現警告訊號,顯示 LCA3

曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 103

上則以 LCA2的混合多元計分模型作為後續說明的依據。

學生評鑑教師教學量表在傳統 Rasch 模型及多元計分模型架構下,經由樣本異質性檢定發 現,評鑑教師的學生樣本群確實存在潛在的異質現象,樣本的分配情況不適合假定為同質性, 而是有限混合分配(McLachlan & Peel, 2000)。在有限混合分配下,不是樣本群可以分拆成兩 個群體各自探討,而是此潛在類別的兩個潛分類組共同捕捉原始分配下樣本的樣貌。因此, 在 Rasch 模型及多元計分模型的參數不變性應有所調整,其參數不變性將受到樣本異質性(潛 分類)的影響,在不同潛分類內依舊維持著各自的 Rasch 模型及多元計分模型下的參數不變 性,但在不同潛分類間各試題的難度及鑑別度參數可能不相同(Rost, 1990, 1997; von Davier & Yamamoto, 2004)。若在分析時忽略樣本潛在異質性的影響,則模型將精簡為傳統 Rasch 模型 及多元計分模型的單一模型(詳如表 3),各試題僅有單一的難度及鑑別度參數。 此外,混合 Rasch 模型及混合多元計分模型對於每一位學生雖然只包含一個特質水準(因 為學生將被歸類到某一特定潛在類別的 IRT 模型裡),但混合 Rasch 模型及混合多元計分模型 被視為是多向度的,原因在於受試者的反應機率除特質水準和試題參數外,也同時由潛在類 別的參數來預測,且試題難度在受試者之間是變動的,就如同多向度模型一樣(Cohen, A. S. & Bolt, 2005)。 由表 5 及表 6 可知,在 Rasch 模型及多元計分模型架構下,當考慮樣本的異質性而成為混 合 Rasch 模型及混合多元計分模型後,兩不同潛分類下各試題的難度及鑑別度參數產生很大的 改變。 原本假定學生樣本為同質性時,在 Rasch 模型下教師通過各試題的難度介於-1.310 至-.620 logit單位之間(詳如表 3)。但進一步考慮樣本的潛在異質性後,在混合 Rasch 模型架構下, 潛在類別第一潛分類組(75.3%)各試題的難度介於-2.453 至-1.224 logit 單位之間,教師可輕 易地通過學生評鑑,在潛在類別第二潛分類組(24.7%)除了 t09、t10 試題難度不顯著外,各 試題的難度介於-.386 至 1.035 logit 單位之間,教師想通過學生評鑑,需要很大程度的努力。 就兩潛在樣本群加以命名,則潛在類別第二潛分類組命名為「嚴格評鑑組」,該潛在類別的學 生給教師的評鑑分數較嚴苛;而潛在類別第一潛分類組則相反,該潛在類別的學生給教師的 評鑑分數較高,因此命名為「寬鬆評鑑組」。 寬鬆評鑑組與嚴格評鑑組的整體給分傾向相反,寬鬆評鑑組給的分數在所有題項中皆偏 高,而嚴格評鑑組給的分數全部偏低,可見不同潛在類別的學生給教師的評鑑分數有很大的 差異。換言之,學生評鑑教師教學的 3.5 分效標參照除了是大學教師評鑑通過與否的標準外, 學生樣本的異質性組成更是決定了大學教師通過與否最重要的因素。當班級內的學生偏向於 寬鬆評鑑組時,大學教師可輕易的通過學生評鑑教師教學,但若班級內的學生組成較偏向於 嚴格評鑑組時,則大學教師即便很努力教學,也會有一定比例難以通過學生評鑑。 由表 6 可知,不以學校行政角度改變學生評鑑教師教學量表的原始填答量尺可以發現,

104 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳 表 5 混合 Rasch 模型試題難度及鑑別度參數估計值摘要(N=6,111) 潛在類別群組1(N=4,602; 75.3%) 潛在類別群組2(N=1,509; 24.7%) 題目 難度(S.E.) 難度(S.E.) t01 -1.623( .044)*** -0.272( .062)*** t02 -1.833( .061)*** 0.194( .074)** t03 -1.654( .056)*** 0.475( .075)*** t04 -1.243( .033)*** -0.110( .052)* t05 -1.980( .066)*** 0.406( .070)*** t06 -1.322( .039)*** 0.430( .069)*** t07 -1.224( .035)*** 0.355( .063)*** t08 -1.712( .077)*** 1.035( .117)*** t09 -1.464( .039)*** 0.064( .064) t10 -1.469( .037)*** 0.049( .060) t11 -1.570( .046)*** -0.386( .064)*** t12 -2.458( .104)*** -0.382( .072)*** t13 -2.106( .079)*** -0.193( .074)** t14 -1.845( .066)*** 0.213( .077)** t15 -2.453( .119)*** 0.285( .090)** 鑑別度為1.288( .028)*** *p < .05. **p < .01. ***p < .001. 在混合多元計分模型架構下,潛在類別第一潛分類組(57.4%)傾向給教師較高的分數(由閥 限值 3 及閥限值 4 可知),且在閥限值 4 許多的參數皆不顯著,表示在學生評鑑教師教學量表 上給教師 4 分及 5 分的學生彼此之間沒有很大的差別;而潛在類別第二潛分類組(42.6%)傾 向給教師較低的分數(由閥限值 3 及閥限值 4 可知),老師要在學生評鑑教師教學量表上獲得 4分及 5 分相對來說較不容易。 混合多元計分模型的結果同混合 Rasch 模型,只是混合 Rasch 模型是以學校所訂定的 3.5 分閥限值作為教師評鑑通過與否的標準,雖然喪失了許多學生原始填答的訊息,但卻也反映 了學生在學生評鑑教師教學量表的填答上,確實存在潛在的異質性差異。 雖然學生評鑑教師教學在國內行之有年,但當學生評鑑教師教學的目的由傳統的改進教 師教學為中心,進而想要真實評鑑教師,決定教師的開課或去留時。除了學校行政單位所訂 定的 3.5 分效標參照評鑑門檻,是否學校行政單位也該認真的思考,大學教師除了應努力達成 70%的教學滿意度外,並無法以人為的方式改變學生樣本的潛在異質性,若班級內學生組成偏 向於嚴格評鑑組時,大學教師即便教學優良也可能不通過學生評鑑,若班級內學生樣本組成

曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 105

表 6

混合多元計分模型試題難度及鑑別度參數估計值摘要(N=6,111) 潛在類別群組1(N=3,507; 57.4%) 題目

閥限值1(S.E.) 閥限值2(S.E.) 閥限值3(S.E.) 閥限值4(S.E.) t01 -3.110( .102)*** -2.281( .078)*** -1.263( .067)*** -0.019( .089) t02 -3.004( .094)*** -2.216( .066)*** -1.179( .067)*** -0.025( .087) t03 -2.899( .092)*** -1.971( .064)*** -0.982( .062)*** -0.067( .083) t04 -2.792( .096)*** -2.004( .079)*** -0.933( .063)*** -0.012( .072) t05 -3.030( .094)*** -2.122( .064)*** -1.106( .062)*** -0.068( .080) t06 -2.893( .092)*** -1.966( .070)*** -0.859( .065)*** 0.218( .084)** t07 -2.768( .090)*** -1.959( .066)*** -0.799( .063)*** 0.330( .080)*** t08 -2.596( .077)*** -1.860( .058)*** -0.860( .061)*** -0.142( .078) t09 -2.982( .101)*** -2.252( .071)*** -1.026( .063)*** -0.148( .082) t10 -3.048( .101)*** -2.309( .074)*** -1.047( .063)*** -0.053( .083) t11 -2.863( .098)*** -2.295( .081)*** -1.323( .072)*** -0.321( .095)** t12 -3.232( .100)*** -2.714( .082)*** -1.688( .073)*** -0.601( .089)*** t13 -3.370( .119)*** -2.578( .081)*** -1.479( .067)*** -0.446( .082)*** t14 -3.045( .097)*** -2.248( .068)*** -1.162( .065)*** -0.248( .078)** t15 -3.164( .096)*** -2.372( .069)*** -1.308( .064)*** -0.229( .081)** 潛在類別群組2(N=2,604; 42.6%) 題目

閥限值1(S.E.) 閥限值2(S.E.) 閥限值3(S.E.) 閥限值4(S.E.) t01 00 -13.810(0.000)*** -3.258( .174)*** -1.009( .057)*** 1.775( .057)*** t02 00 -14.006(0.000)*** -3.442( .218)*** -0.915( .056)*** 1.793( .056)*** t03 -5.081(1.057)*** -3.270( .165)*** -0.795( .055)*** 1.830( .063)*** t04 -5.064(1.128)*** -2.910( .147)*** -0.876( .053)*** 1.569( .066)*** t05 -13.879(0.000)*** -3.255( .167)*** -0.930( .059)*** 1.856( .072)*** t06 -4.915(0.505)*** -3.061( .181)*** -0.661( .055)*** 2.309( .096)*** t07 -4.943(0.651)*** -3.290( .196)*** -0.684( .054)*** 2.509( .159)*** t08 -13.821(0.000)*** -3.193( .219)*** -0.622( .056)*** 1.929( .081)*** t09 -1,515.642(0.000)*** -3.452( .168)*** -0.879( .055)*** 2.222( .118)*** t10 -14.036(0.000)*** -3.263( .169)*** -0.855( .054)*** 2.068( .096)*** t11 -4.614(0.820)*** -3.251( .178)*** -0.976( .055)*** 1.875( .076)*** t12 -13.971(0.000)*** -3.800( .186)*** -1.273( .063)*** 1.629( .087)*** t13 -14.067(0.000)*** -3.526( .178)*** -1.115( .060)*** 1.739( .107)*** t14 -13.939(0.000)*** -3.353( .166)*** -0.919( .057)*** 1.839( .120)*** t15 -14.121(0.000)*** -3.454( .229)*** -1.030( .061)*** 1.821( .100)*** 鑑別度為1.561( .028)*** **p < .01. ***p < .001.

106 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳

偏向於寬鬆評鑑組時,大學教師即便教學有待改進,也可輕易通過學生評鑑,換言之,以學 生評鑑教師教學來決定教師的開課或去留可行嗎?

此外,過往學生評鑑教師教學的研究(曾明基等,2011;Beran & Violato, 2005; Chang & Ross, 2006; Cohen, E. H., 2005; Marsh, 2007; Spooren & Mortelmans, 2006)皆指出,學生的背景 變項差異,有可能影響到學生在學生評鑑教師教學量表的填答分數。此一共變數(學生背景 變項)的加入可幫助潛在類別模型在實證上更好的被分類(Smit, Kelderman, & Flier, 1999)。 因此,在混合 Rasch 模型以及混合多元計分模型架構下,將進一步納入學生的背景變項做探討。 Smit 等(1999)也指出,當共變數與潛在類別之間的連結性增強,試題參數與潛在類別 的分類群組可被更好的呈現,而在本研究中所納入的共變數皆為過往學生評鑑教師教學議題 探討上常納入的學生背景變項。本研究所納入的背景變項包含學生的系所差異(分為理工學 院,N=1,353;管理學院,N=688;教育學院,N=1,367;藝術學院,N=308;以及人文社 會學院,N=2,395,以人文社會學院為對照組)、科目性質(分為必修,N=2,733;選修,N =1,715;以及學程,N=1,663,以學程為對照組)、學生年級(分為一至四年級,一年級有 2,359 人、二年級有 1,696 人、三年級有 1,424 人、四年級有 632 人,數值愈大表示年級愈高)、學 生性別(分為男生,N=2,520;女生,N=3,591,以女生為對照組),以及學習興趣(其中包 含兩個題目:我會準時繳交作業、我會與同學討論功課,皆為五點式量表,數值愈大代表學 生學習愈感興趣)。 加入共變數後的混合 Rasch 模型及混合多元計分模型的整體適配度明顯較未加入共變數 前的模型佳。加入共變數後的混合 Rasch 模型的整體適配度為 LRT=-30,767.450、AIC= 61,618.901、BIC=61,901.050、ABIC=61,767.586、Entropy= .647,與表 4 未加入共變數的 混合 Rasch 模型相比,除了整體適配度較好外,潛在類別的分類結果也較佳。而加入共變數後 的 混 合 多 元 計 分 模 型 的 整 體 適 配 度 為 LRT = -66,072.027 、 AIC = 132,408.054 、 BIC = 133,294.810、ABIC=132,875.350、Entropy= .828,其整體適配度與潛在類別的分類結果也與 表 4 未加入共變數的混合多元計分模型佳。 由表 7 可知,在混合 Rasch 模型架構下,當學校以 3.5 分閥限值作為決定教師開課或去留 的效標參照時,理工學院相對於人文社會學院,出現在寬鬆評鑑組的機會為 73.57%(e-.307 = .7357),表示理工學院相對於人文社會學院出現在嚴格評鑑組的機會高出 35.93%(1÷e-.307 =1.3593);而藝術學院相對於人文社會學院出現在寬鬆評鑑組的機會為 186.45%。表示系所 的差別會影響到學生出現在嚴格評鑑組以及寬鬆評鑑組的機率。此外,科目性質對評鑑教師 沒有影響。而學生年級愈高,出現在寬鬆評鑑組的機率會增加。且學生的學習興趣愈佳,出 現在寬鬆評鑑組的機率也會增加。整體而言,學生的背景變項確實會影響到學生出現在嚴格 評鑑組以及寬鬆評鑑組的機率,因此,當學校以全體教師皆相同的 3.5 分閥限值作為決定教師 開課或去留的效標參照時,其評鑑的結果將有待商榷,畢竟學生的背景差異將影響到其在學

曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 107 表 7 學生背景變項對混合 IRT 模型的影響(N=6,111) 學生背景變項 混合Rasch模型C#1 混合多元計分模型C#1 系所差異 理工學院 -.307** * .044*** 管理學院 -.109** * .087*** 教育學院 -.074** * .170*** 藝術學院 .623*** .977*** 科目性質 必修 .125*** .225*** 選 修 .237*** .332*** 學生年級 .158*** -.037** * 學生性別 .094*** .271*** 學習興趣 討論功課 .499*** .552*** 溫習功課 .714*** .363*** 註:C#1 表示以混合模型中的第二潛在類別為參照組;學生背景變項影響潛在類別的迴歸係數為勝 敗比(odds ratio)。 *p < .05. **p < .01. ***p < .001. 生評鑑教師教學量表給分的嚴格或是寬鬆。 從學生原始填答分數的混合多元計分模型觀之,不同系所、科目性質、學生性別以及學 習興趣,皆會影響到學生出現在嚴格評鑑組以及寬鬆評鑑組的機率,並進而影響到給教師的 評鑑分數多寡。從學生背景變項對混合 Rasch 模型,以及混合多元計分模型的潛在類別影響可 以發現,學生背景變項的不同,將影響到教師評鑑通過與否以及學生給教師的分數差異。這 或許是學校在評鑑教師教學時應加以考量的。

伍、結論與建議

一、結論

過往探究影響學生評鑑教師教學的實證研究,主要是以改進教師教學的角度出發,研究 結果可作為大學教師精進教學的參考,但當學生評鑑教師教學的目的不再是以改進教師教學 為中心,而是用來決定教師的開課或去留時,對於學生評鑑教師教學的結果,應以更審慎的 態度觀之。108 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳 有別於過往學生評鑑教師教學的實證探討皆建構在古典測驗理論上,本研究以近代測驗 理論進行模型建構並考量樣本的潛在異質性。研究發現,當學生評鑑教師教學量表僅建構在 IRT模型時,量表各題項在 Rasch 模型的難度參數,以及多元計分模型的閥限值均甚佳,表示 東部某大學的學生評鑑教師教學量表可作為有效評鑑大學教師教學的參考依據,並進一步決 定大學教師的開課和去留。但在 IRT 模型架構下考慮樣本潛在異質差異而成為混合 IRT 模型 時,發現 Rasch 模型以及多元計分模型皆受到樣本潛在異質性的影響。在混合 IRT 模型架構下 包含兩個潛分類組,其中一個潛分類組的學生給教師的評鑑分數較高,而另一個潛分類組的 學生給教師的評鑑分數較低,兩個潛分類組的差異將影響到學生評鑑教師教學的評鑑結果, 因此,以學生評鑑教師教學的結果決定大學教師的開課和去留將有待商榷。此外,背景變項 的差異也會影響到學生出現在兩個潛分類組的機率。

二、建議

本研究目的僅是想凸顯以學生評鑑教師教學來決定教師的開課或去留的可行性,並無否 定學生評鑑教師教學期許教師改善教學的良善初衷。針對上述研究結果,提出以下建議供大 學行政單位與教師參考。(一)以 3.5 分閥限值作為評鑑教師教學效標參照的合理性

東部某大學學生評鑑教師教學量表各題項的滿分皆為 5 分,以 3.5 分作為評鑑教師教學通 過與否的標準雖然立意良善,但行政單位若改變通過評鑑的閥限值分數,則大學教師在各試 題通過的比例將隨之改變。對於通過評鑑的標準,除了由行政單位訂定外,是否應提出強而 有力的文獻支持來說服大學教師,而不是僅以行政命令為依歸。(二)學生樣本潛在異質性的考量

行政單位以學生評鑑教師教學結果作為教師開課或去留的重要依據,其出發點假定學生 可真實且公正地評鑑大學教師。但當學生樣本的組成存在潛在異質性差異時,則評鑑的結果 將產生很大的差異,並無法有效地評鑑大學教師真實的教學能力。此外,不同背景變項的學 生,出現在嚴格評鑑組及寬鬆評鑑組的機率也不相同。而學生樣本的異質性組成及背景變項 差異,並無法以人為的操弄或分組來改變,將可能對學生評鑑教師教學產生不公平的結果。 此部分是行政單位在審視學生評鑑教師的結果時應該加以考量的。 除此之外,本研究是國內、外學生評鑑教師教學議題探討上,唯一考慮樣本潛在異質性 差異的學生評鑑教師教學研究,因此仍有許多不足之處,茲說明供後續研究參考:(一)學生評鑑教師教學混合模型的理論發展及實證研究不足

此篇研究在國內、外學生評鑑教師教學的議題探討上,是第一篇考慮到樣本潛在異質性 的差異對學生評鑑教師教學的影響,因此,在研究方法上沒有過往學生評鑑教師的實證研究曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 109

可以支持,僅能從混合模型相關的文獻來加以佐證(Asparouhov & Muthén, 2008; Muthén, B., 2006; Muthén, B. & Asparouhov, 2006; Muthén, B. et al., 2006; Rost, 1990, 1997; von Davier & Yamamoto, 2004),此一理論不足之處,有待後續的研究者加以補強,並對本研究的分析結果 提出合理的批判。

(二)學生評鑑教師教學混合模型的研究推論不足

本研究目的主要在探討以學生評鑑教師教學量表決定教師開課或去留的合理性,然而, 僅以東部某大學大學部學生為分析單位,在研究推論上確有不足之處,研究結果並無法加以 類推至各大學院校。此外,不同學校的大學部學生及研究所學生的評鑑方式是否有所差異、 潛在樣本群是否不相同、學生評鑑教師教學通過與否的效標參照值的差異等,皆是後續研究 者可加以考量和進一步探討之處。(三)本研究估計法的可能缺失

本研究所估計的混合 Rasch 模型以及混合多元計分模型皆使用 Mplus 軟體進行估計 (Muthén, L. K. & Muthén, 2006)。Mplus 在估計混合 IRT 模型所使用的函數建構在條件反應機 率的邏輯斯分配。而混合 IRT 模型最大概似估計法的優化處理在 Mplus 中使用兩步驟的分析 方式。在第一步驟中,使用 EM 算則的迭代(iterative)運算,在 E 步驟中每一個潛在類別的 期望組型次數是基於觀察次數和模型參數的初步估計,這些類別的組型次數是藉由對觀察次 數的比例加權而獲得,而在 M 步驟中模型參數的最大概似估計是基於類別中期望組型次數而 求得,對於每一潛在類別試題參數和分數參數是分別被估計的,必須使得在一個潛在類別中, 資料的對數概似函數的值最大。L. K. Muthén 與 Muthén(2006)指出,EM 算則的優化處理首 先必須設定許多的隨機起始值,這些隨機起始值在估計後出現最高的概似函數者,將用於最 後的優化。在第二步驟中,在 Mplus 語法中使用 TYPE=MIXTURE 以及 ALGORITHM= INTEGRATION的語法設定,Mplus 將使用最大概似估計法伴隨強韌標準誤的數值分析以進行 最後的模型估計。然而,相關的實證研究指出,在混合模型中使用最大概似估計法將可能產 生以下的諸多缺失: 1.混合模型的最大概似估計法可能很難找出整體的(global)最大概似估計。模型估計將 因 過 小 的 樣 本 數 或 是 混 合 模 型 的 潛 在 分 類 無 法 被 有 效 地 區 分 而 導 致 模 型 收 斂 失 敗 (Frühwirth-Schnatter, 2006)。如表 4 混合多元計分模型的三個潛分類,因無法被有效地區分 而導致模型無法收斂。 2.混合模型的概似函數沒有邊界,可能包含許多虛假的局部極大值模型(McLachlan & Peel, 2000)。為了避免局部極大值的產生,研究者僅能在 Mplus 中增大隨機起始值和收斂值 的數量(Mplus 原始設定隨機起始值是十個,收斂值是二個)。研究者以人為的方式將隨機起 始值增加到一百個,收斂值十個,以避免局部極大值的產生,但此一設定將會增加電腦很長110 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳 的估算時間。然而,這仍無法完全解決局部極大值的可能出現。 3.在混合模型中所估計參數的標準誤並非直接由最大概似估計法所估計獲得,實際上是使 用 EM 算則所估計獲得。而如何在混合模型架構下直接使用最大概似估計法進行參數估計, 有待後續心理計量學者的努力。 4.誠如 McLachlan 和 Peel(2000)所言,在使用最大概似估計的混合模型時,樣本數必須 很大,才能夠使用 EM 算則的近似逼近。但是多大的樣本數才算合理,加入共變數後的混合 模型需有多大的樣本數才能合理估計,則非本研究可以回答的。

誌謝

感謝國立臺中教育大學教育測驗統計研究所楊志堅老師、國立彰化師範大學輔導與諮商 學系王郁琮老師、國立中山大學人力資源管理研究所謝爵安老師慨然提供混合模型以及 IRT 相關資源,並與研究團隊透過 E-mail 及電話切磋交流,使此篇研究增色不少;也感謝 2 位審 稿者細緻且嚴謹的審查,研究團隊要在此致上最高的敬意與謝意!曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 111

參考文獻

一、中文文獻

周祝瑛(2009)。政大教師教學評鑑中「教學意見調查表」之研究。取自 http://www3.nccu.edu. tw/~iaezcpc/C-Teaching%20Survey%20Form%20Research.htm

【Chou, C.-P. (2009). National Cheng Chi University evaluation of teaching. Retrieved from http://www3.nccu. edu.tw/~iaezcpc/C-Teaching%20Survey%20Form%20Research.htm】

張德勝(2002)。學生評鑑教師教學:理論、實務與態度。臺北市:揚智。

【Chang, T.-S. (2002). Student ratings of instruction: Theory, practice and attitudes. Taipei, Taiwan: Yang-Chih Book.】

張德勝、邱于真、羅寶鳳(2011)。題目順序對學生評鑑教師教學與學生自評影響之探索性研 究。測驗學刊,58(2),367-389。

【Chang, T.-S., Qiu, Y.-Z., & Lo, P.-F. (2011). The exploratory study on the effects of question order on student ratings of instruction and student self-evaluation. Psychological Testing, 58(2), 367-389.】

曾明基、邱于真、張德勝、羅寶鳳(2011)。學生認知歷程對學生評鑑教師教學的影響:階層 線性模式分析。課程與教學季刊,14(3),157-180。

【Tseng, M.-C., Qiu, Y.-Z., Chang, T.-S., & Lo, P.-F. (2011). HLM analysis of the effects of cognitive process on student ratings of instruction. Curriculum & Instruction Quarterly, 14(3), 157-180.】

曾明基、張德勝、羅寶鳳、邱于真(2012)。學生評鑑教師教學題目安排順序不同對學生評鑑 教師的影響:MI 與 MMI 分析取向。測驗學刊,59(1),131-156。

【Tseng, M.-C., Chang, T.-S., Lo, P.-F., & Qiu, Y.-Z. (2012). The effects of question order difference on student ratings of instruction: MI and MMI analysis approaches. Psychological Testing, 59(1), 131-156.】

二、外文文獻

Asparouhov, T., & Muthén, B. (2008). Multilevel mixture models. In G. R. Hancock & K. M. Samuelsen (Eds.), Advances in latent variable mixture models (pp. 27-51). Charlotte, NC: Information Age.

Beran, T., & Violato, C. (2005). Ratings of university teacher instruction: How much do student and course characteristics really matter? Assessment & Evaluation in Higher Education, 30(6), 593-601. doi:10.1080/02602930500260688

Bowling, N. A. (2008). Does the relationship between student ratings of course easiness and course quality vary across schools? The role of school academic rankings. Assessment & Evaluation in Higher Education, 33(4), 455-464. doi:10.1080/02602930701562965

Celeux, G., & Soromenho, G. (1996). An entropy criterion for assessing the number of clusters in a mixture model. Journal of Classification, 13(2), 195-212. doi:10.1007/BF01246098

112 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳

Chang, T.-S. (2005). The validity and reliability of student ratings: Comparison between paper- pencil and online survey. Chinese Journal of Psychology, 47(2), 113-125.

Chang, T.-S., & Ross, W. (2006). The influence of instructor, student, and course characteristics on student ratings: What do faculty and students believe? Journal of National Hualien University of Education, 23, 1-28.

Cohen, E. H. (2005). Student evaluations of course and teacher: Factor analysis and SSA approaches. Assessment & Evaluation in Higher Education, 30(2), 123-136. doi:10.1080/0260293042000 264235

Cohen, A. S., & Bolt, D. M. (2005). A mixture model analysis of differential item functioning. Journal of Educational Measurement, 42(2), 133-148. doi:10.1111/j.1745-3984.2005.00007 d’Apollonia, S., & Abrami, P. C. (1997). Navigating student ratings of instruction. American

Psychologist, 52(11), 1198-1208. doi:10.1037/0003-066X.52.11.1198

Donald, J. G. (2006). Enhancing the quality of teaching in Canada. New Directions for Higher Education, 2006(133), 23-31. doi:10.1002/he.202

Embretson, S., & Yang, X. (2006). Item response theory. In J. L. Green, G. Camilli, & P. B. Elmore (Eds.), Handbook of complementary methods in education research (pp. 385-409). Mahwah, NJ: Lawrence Erlbaum Associates.

Frühwirth-Schnatter, S. (2006). Finite mixture and markov switching models. New York, NY: Springer.

Greenwald, A. G., & Gillmore, G. M. (1997). Grading leniency is a removable contaminant of student ratings. American Psychologist, 52(11), 1209-1217. doi:10.1037/0003-066X.52.11.1209 Hambleton, R. K., & Swaminathan, H. (1985). Item response theory: Principles and applications.

Boston, MA: Kluwer-Nijhoff.

Kreber, C. (2006). Setting the context: The climate of university teaching and learning. New Directions for Higher Education, 2006(133), 5-11. doi:10.1002/he.200

Marsh, H. W. (2007). Students’ evaluations of university teaching: Dimensionality, reliability, validity, potential biases, and usefulness. In R. P. Perry & J. C. Smart (Eds.), The scholarship of teaching and learning in higher education: An evidence-based perspective (pp. 319-383). Dordrecht, the Netherlands: Springer. doi:10.1007/1-4020-5742-3_9

Masters, G. N. (1982). A Rasch model for partial credit scoring. Psychometrika, 47(2), 149-174. doi:10.1007/BF02296272

Masters, G. N. (1985). A comparison of latent trait and latent class analysis of Likert-type data. Psychometrika, 50(1), 69-82. doi:10.1007/BF02294149

曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 113

Masters, G. N. (1988). The analysis of partial credit scoring. Applied Measurement in Education, 1(4), 279-297. doi:10.1207/s15324818ame0104_2

McDonald, R. P., & Mok, M. C. (1995). Goodness of fit in item response models. Multivariate Behavioral Research, 30(1), 23-40. doi:10.1207/s15327906mbr3001_2

McKeachie, W. J. (1997). Student ratings: The validity of use. American Psychologist, 52(11), 1218-1225. doi:10.1037/0003-066X.52.11.1218

McLachlan, G., & Peel, D. (2000). Finite mixture models. New York, NY: John Wiley & Sons. Muraki, E. (1992). A generalized partial credit model: Application of an EM algorithm. Applied

Psychological Measurement, 16(2), 159-176. doi:10.1177/014662169201600206

Muthén, B. (2006). Should substance use disorders be considered as categorical or dimensional? Addiction, 101, 6-16. doi:10.1111/j.1360-0443.2006.01583.x

Muthén, B., & Asparouhov, T. (2006). Item response mixture modeling: Application to tobacco dependence criteria. Addictive Behaviors, 31(6), 1050-1066. doi:10.1016/j.addbeh.2006.03.026 Muthén, B., Asparouhov, T., & Rebollo, I. (2006). Advances in behavioral genetics modeling using

Mplus: Applications of factor mixture modeling to twin data. Twin Research and Human Genetics, 9(3), 313-324. doi:10.1375/183242706777591317

Muthén, L. K. (2010, February 11). Re: Model fit index WRMR [Online forum comment]. Retrieved from http://www.statmodel.com/discussion/messages/9/5096.html

Muthén, L. K., & Muthén, B. O. (2006). Mplus user’s guide (4th ed.). Los Angeles, CA: Author. Nylund, K. L., Asparouhov, T., & Muthén, B. O. (2007). Deciding on the number of classes in latent

class analysis and growth mixture modeling: A monte carlo simulation study. Structural Equation Modeling, 14(4), 535-569. doi:10.1080/10705510701575396

Rice, R. E. (2006). Enhancing the quality of teaching and learning: The U.S. experience. New Directions for Higher Education, 2006(133), 13-22. doi:10.1002/he.201

Rost, J. (1990). Rasch models in latent classes: An integration of two approaches to item analysis. Applied Psychological Measurement, 14(3), 271-282. doi:10.1177/014662169001400305 Rost, J. (1997). Logistic mixture models. In W. J. van der Linden & R. K. Hambleton (Eds.),

Handbook of modern item response theory (pp. 449-463). New York, NY: Springer. doi:10.1007/978-1-4757-2691-6_26

Sara, J. F., & Christine, D. (2006). Non normal and categorical data in structural equation modeling. In G. R. Hancock & R. O. Mueller (Eds.), Structural equation modeling: A second course (pp. 269-314). Greenwich, CT: Information Age.

114 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳

Methods of Psychological Research Online, 4(3), 19-32.

Spooren, P., & Mortelmans, D. (2006). Teacher professionalism and student evaluation of teaching: Will better teachers receive higher ratings and will better students give higher ratings? Educational Studies, 32(2), 201-214. doi:10.1080/03055690600631101

Vincent, F. F., & Kennon, M. S. (2003). Student psychological need satisfaction and college teacher-course evaluations. Educational Psychology, 23(3), 235-247. doi:10.1080/01443410 32000060084

Vincent, F. F., & Kennon, M. S. (2008). Teacher support, student motivation, student need satisfaction, and college teacher course evaluations: Testing a sequential path model. Educational Psychology, 28(6), 711-724. doi:10.1080/01443410802337794

von Davier, M., & Yamamoto, K. (2004). Partially observed mixtures of IRT models: An extension of the generalized partial-credit model. Applied Psychological Measurement, 28(6), 389-406. doi:10.1177/0146621604268734

Webler, W. D. (2006). German policy perspectives on enhancing the quality of student learning by university teaching. New Directions for Higher Education, 2006(133), 53-62. doi:10.1002/he. 205

Yen, W. M., & Fitzpatrick, A. R. (2006). Item response theory. In R. L. Brennan (Ed.), Educational measurement (4th ed., pp. 111-153). Westport, DC: National Council on Measurement in Education.

曾明基、邱皓政、張德勝、羅寶鳳 量表可決定教師去留嗎? 115

附錄 學生評鑑教師教學量表題目內容說明

題目 t01 教師有提供完整的教學計畫表(含評分方法與標準) t02 教師課前準備充分,上課內容豐富充實 t03 教師表達條理分明、清晰流暢 t04 教師使用適當的教學方法或媒體(黑板、投影機等),來增進教學效果 t05 教師授課內容有助於提升學生的學習能力與專業知識 t06 教師對於課程進度安排適當,並能充分運用課堂時間 t07 教師對於教材內容的安排難易適中 t08 整體而言,我在本課程收穫豐富 t09 教師對學生的學習評量公平合理 t10 教師所指定的作業有助於本課程的學習 t11 教師能夠準時上課,如有請假會安排調課或補課 t12 教師教學認真 t13 教師樂於解決學生的學習問題 t14 教師授課時,能與學生維持良好互動 t15 整體而言,教師的教學表現優良116 量表可決定教師去留嗎? 曾明基、邱皓政、張德勝、羅寶鳳

Journal of Research in Education Sciences 2013, 58(1), 91-116

doi:10.3966/2073753X2013035801004

Is Using a SRI to Determine the Fate of

Teachers or Commencement of Work Suitable?

A Mixture IRT Analysis

Ming-Ci Tseng

Haw-Jeng Chiou

Department of Curriculum Design and Human Potentials Development, National Dong Hwa University

College of Management, National Taiwan Normal University

Te-Sheng Chang

Pao-Feng Lo

Department of Curriculum Design and Human Potentials Development, National Dong Hwa University

Department of Curriculum Design and Human Potentials Development, National Dong Hwa University

Abstract

This study examines the effects of variability in student ratings regarding instruction on decision-making for faculty teaching evaluation. A total of 6,111 undergraduate students from 173 classes in a university on the east coast of Taiwan were included in the research sample.

This study is different from previous studies regarding student ratings for instruction that are constructed in classical test theory. We use item response theory to analyze the heterogeneity of students, to rigorously examine the effects on student ratings regarding instruction. The results show that teachers may easily exceed the teaching criterion score set by the university when not considering the heterogeneity of the student ratings. However, the different latent types of the variability of student ratings may be important for interpreting the results of different student rating scores. The recommendations for university teaching and student ratings regarding instruction are created based on the results from this study.

Keywords: student ratings of instruction, mixture IRT analysis

Corresponding Author: Ming-Ci Tseng, E-mail: d9988101@ems.ndhu.edu.tw Manuscript received: Apr. 18, 2012; Revised: Dec. 13, 2012; Accepted: Feb. 23, 2013.